Subsumption-Architektur ist eine reaktive Roboterarchitektur, die stark mit verhaltensbasierter Robotik in Verbindung steht und in den 1980er und 1990er Jahren sehr beliebt war. Der Begriff wurde 1986 von Rodney Brooks und seinen Kollegen eingeführt. Die Subsumtion hatte einen großen Einfluss auf die autonome Robotik und andere Bereiche der Echtzeit-KI.

Überblick

Subsumption-Architektur ist eine Kontrollarchitektur, die im Gegensatz zur traditionellen KI oder GOFAI vorgeschlagen wurde. Anstatt Verhalten durch symbolische mentale Repräsentationen der Welt zu leiten, verknüpft die Subsumtionsarchitektur sensorische Informationen auf intime und Bottom-up-Weise mit der Aktionsauswahl.

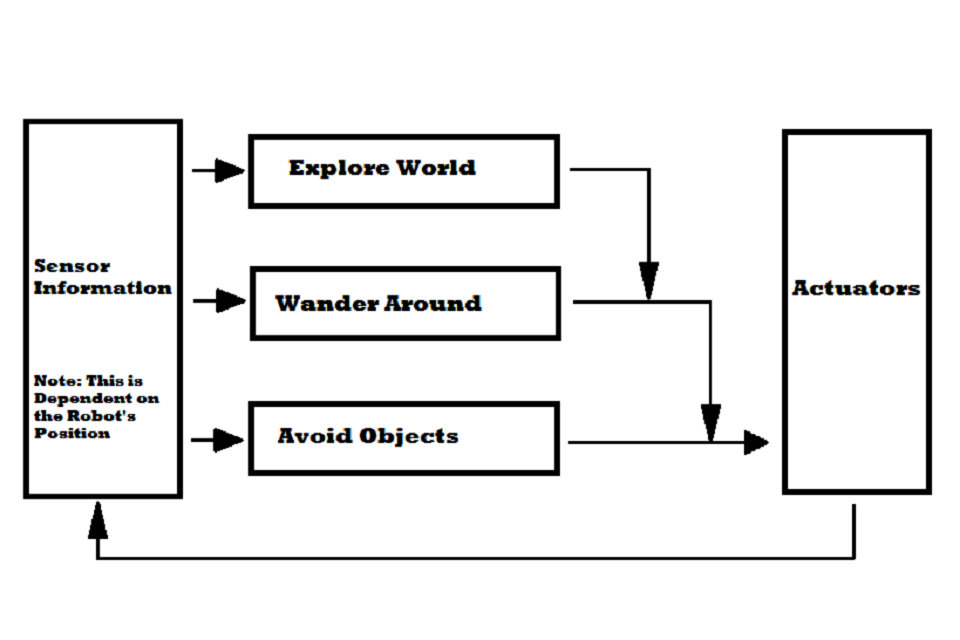

Dies geschieht, indem das gesamte Verhalten in Unterverhalten zerlegt wird. Diese Unterverhalten sind in einer Hierarchie von Schichten organisiert. Jede Schicht implementiert eine bestimmte Ebene der Verhaltenskompetenz, und höhere Ebenen sind in der Lage, niedrigere Ebenen zu subsumieren (= untere Ebenen zu einem umfassenderen Ganzen zusammenzufassen), um ein brauchbares Verhalten zu schaffen. Zum Beispiel könnte die unterste Schicht eines Roboters „ein Objekt vermeiden“ sein. Die zweite Schicht wäre „herumlaufen“, die unter der dritten Schicht „die Welt erkunden“ verläuft. Da ein Roboter über die Fähigkeit verfügen muss, „Objekte zu vermeiden“, um effektiv „herumwandern“ zu können, erstellt die Subsumtionsarchitektur ein System, in dem die höheren Schichten die untergeordneten Kompetenzen nutzen. Die Schichten, die alle Sensorinformationen empfangen, parallel arbeiten und Ergebnisse generieren. Diese Ausgänge können Befehle an Aktoren sein oder Signale, die andere Schichten unterdrücken oder sperren.

Eigenschaften

Körperlichkeit

Agenten sind irgendwie in der Umgebung verankert, sie haben einen Körper mit ihren Sensoren und Aktuatoren, und sie erkennen und reagieren auf Veränderungen in der Umgebung.

Situation

Agenten sind Teil ihrer realen Umgebung, mit der sie interagieren. Dies beeinflusst das Verhalten des Agenten.

Intelligenz

Die Intelligenz des Agenten wird vorwiegend durch die Kollision des Agenten mit der realen Umgebung, seine Reaktionen und Reize gebildet.

Entstehung der

Die Intelligenz des Systems als Ganzes entsteht auf eine aufstrebende Weise, dh die Interaktion seiner einzelnen Teile.

Keine explizite Wissensrepräsentation

Subsoup-Architektur hat kein explizites Weltmodell. Dies bedeutet, dass der Roboter keinen vereinfachten Überblick über die umgebende Welt hat. Die Vorteile liegen auf der Hand. Agenten machen keine Vorhersagen über die Welt, sodass sie in einer unvorhersehbaren Umgebung sehr gut funktionieren können. Sparen Sie Zeit zum Lesen und Schreiben. Es spart auch die Zeit des von diesem Modell verwendeten Algorithmus. Es wird auch Probleme mit einem Weltmodell geben, das nicht mit der realen Welt übereinstimmen muss. Es hat aber auch Nachteile. Das System ist dann rein reaktiv. Das bedeutet, dass es nur auf das reagiert, was in der Welt passiert. Mit anderen Worten, die Welt bestimmt, was sie tun will.

Verteilen

Das Verhalten verteilt sich auf endliche Automaten, die verschiedene Aufgaben ausführen. Dadurch können sie auf Wettbewerbsereignisse in der Umgebung reagieren. Das Gesamtverhalten ist die ungefähre Summe der endlichen Automaten. Die Architektur des Subsystems ist parallel und asynchron, da endliche Automaten unabhängig voneinander arbeiten. Alle endgültigen Maschinen laufen ständig, und da sie ein eigenes Timing haben können, benötigen sie keine Synchronisation.

Schichtung

Untergrundarchitektur besteht aus Schichten, in denen jede ein bestimmtes Verhalten implementiert, und besteht aus einem oder mehreren endlichen Automaten. Die Architektur des Subsystems wird als modular betrachtet, da jeder endliche Automat eine unabhängige Aufgabe ausführt. Jede fertige Maschine verfügt über eine Reihe von Eingabe- und Ausgabezeilen. Final Machines sind Prozessoren, die Nachrichten miteinander senden und Datenstrukturen speichern können. Prozessoren arbeiten asynchron und sind gleichwertig. Sie überwachen ihre Eingaben und senden Berichte an die Ausgaben. Die endgültige Maschine berücksichtigt immer die zuletzt empfangene Nachricht. Aus diesem Grund kann die Nachricht verloren gehen, wenn die neue Nachricht eintrifft, bevor die ältere Nachricht verarbeitet wurde. Es gibt keine Kontrolle innerhalb der Schicht und es gibt keine andere Form der Kommunikation zwischen Prozessoren, dh es gibt keinen gemeinsam genutzten Speicher. Jedes Modul kümmert sich nur um seine Aufgabe. Höhere Schichten haben Zugriff auf Sensoren und beeinflussen das Verhalten niedrigerer Schichten, indem sie die Eingabe beschränken oder die Ausgabe bestimmter endlicher Automaten auf niedrigeren Ebenen unterdrücken.

Dies ist der Mechanismus, durch den höhere Schichten die Rolle der unteren Schichten einschließen.

Navigation

Die wichtigste Agentenfähigkeit, die auf der Subsumtionsarchitektur basiert, besteht darin, sich um die Welt zu bewegen und zu vermeiden, dass Objekte bewegt und bewegt werden. Die Navigation ist eine der Hauptaufgaben, die Agenten zu erledigen haben, und diese Aufgabe ist extrem reaktiv (im Vergleich zu anderen kognitiven Agenten). Die Navigation erfolgt meist in mehreren Ebenen. Das unterste Modul vermeidet Objekte (auch für diejenigen, die plötzlich auftauchen) und das höhere Level führt den Agenten in eine bestimmte Richtung und ignoriert die Hindernisse. Diese Kombination bietet eine einfache Möglichkeit, ohne explizite Routenplanung von A nach B zu gelangen.

Andere

Agenten arbeiten in Echtzeit und sind in erster Linie darauf ausgelegt, sich in einer realen, dynamischen und komplexen Welt zu bewegen.

Gründe für den Ursprung

Ein Grund für die Erstellung einer Subsumtionsarchitektur war die Tatsache, dass die Autoren die folgenden Anforderungen und Anforderungen für die Erstellung autonomer mobiler Roboter erfüllen wollten.

Viele Ziele

Der Roboter kann mehr Ziele haben, die miteinander in Konflikt stehen und auf irgendeine Weise angegangen werden müssen. Zum Beispiel kann ein Roboter versuchen, einen bestimmten Punkt vor ihm zu erreichen, und gleichzeitig muss er Hindernissen ausweichen, die unterwegs sind. Es muss auch in kürzester Zeit an einen Ort gelangen und gleichzeitig Energie sparen. Es ist daher klar, dass die Wichtigkeit und Priorität der Ziele relativ und kontextabhängig sind. Es ist sicherlich wichtiger, die Gleise abzufahren, wenn der Zug fährt, bevor die Gleisschwellen überprüft werden.

Weitere Sensoren

Der Roboter kann mehrere Sensoren (Kameras, Infrarotsensoren, akustische Sensoren usw.) aufweisen. Alle Sensoren können möglicherweise fehlerhaft sein. Darüber hinaus besteht häufig keine direkte analytische Beziehung zwischen Sensorwerten und erforderlichen physikalischen Größen. Einige Sensoren können sich in den von ihnen gemessenen Bereichen überlappen. Häufig können inkonsistente Messwerte auftreten – manchmal aufgrund eines Sensorfehlers und manchmal aufgrund von Messbedingungen -, wenn der Sensor außerhalb seines Bereichs verwendet wird. Häufig stehen keine genauen analytischen Merkmale des Geltungsbereichs zur Verfügung. Der Roboter muss die Entscheidung unter den oben genannten Bedingungen treffen können.

Robustheit

Der Roboter muss robust sein. Wenn einige Sensoren ausfallen, müssen sie sich darauf einstellen können, sich nur auf die funktionierenden Sensoren zu verlassen. Wenn sich die Umgebung drastisch ändert, sollte sie immer noch in der Lage sein, vernünftiges Verhalten zu erreichen – anstatt schockiert zu bleiben oder ziellos und unsinnig herumzulaufen. Es ist auch angebracht, wenn es fortfahren kann, wenn Fehler auf seinen Prozessoren auftreten.

Skalierbarkeit

Wenn mehr Roboter zum Roboter hinzugefügt werden, benötigen sie mehr Verarbeitungskapazität. Andernfalls können ihre ursprünglichen Fähigkeiten im Laufe der Zeit beeinträchtigt werden.

Tor

Die Subsumption-Architektur greift das Problem der Intelligenz aus einer wesentlich anderen Perspektive als die traditionelle KI an. Enttäuscht von der Leistung des Roboters Shakey und ähnlichen, von der Repräsentation inspirierten Projekten, begann Rodney Brooks mit der Entwicklung von Robotern, die auf einer anderen Vorstellung von Intelligenz basierten und unbewussten Denkprozessen ähnelten. Anstatt Aspekte der menschlichen Intelligenz durch Symbolmanipulation zu modellieren, zielt dieser Ansatz auf Echtzeitinteraktion und praktikable Reaktionen auf eine dynamische Labor- oder Büroumgebung ab.

Das Ziel wurde von vier Schlüsselideen bestimmt:

Platzhaltbarkeit – Eine Hauptidee einer platzierten KI ist, dass ein Roboter in der Lage sein sollte, innerhalb eines menschenähnlichen Zeitrahmens auf seine Umgebung zu reagieren. Brooks argumentiert, dass lokalisierte mobile Roboter die Welt nicht über einen internen Satz von Symbolen repräsentieren sollten und dann auf dieses Modell reagieren sollten. Stattdessen behauptet er, dass „die Welt ihr eigenes bestes Modell ist“, was bedeutet, dass richtige Wahrnehmungs-zu-Aktion-Einstellungen verwendet werden können, um direkt mit der Welt zu interagieren, anstatt sie zu modellieren. Trotzdem modelliert jedes Modul / Verhalten immer noch die Welt, jedoch auf einem sehr niedrigen Niveau, in der Nähe der sensomotorischen Signale. Diese einfachen Modelle verwenden notwendigerweise hartcodierte Annahmen über die Welt, die in den Algorithmen selbst kodiert sind, vermeiden jedoch die Verwendung von Speicher, um das Verhalten der Welt vorherzusagen, stattdessen auf möglichst direktes sensorisches Feedback.

Verkörperung – Brooks argumentiert, dass der Bau eines verkörperten Agenten zwei Dinge bewirkt. Die erste ist, dass der Konstrukteur dazu gezwungen wird, ein integriertes physisches Steuerungssystem zu testen und zu erstellen, nicht theoretische Modelle oder simulierte Roboter, die in der physischen Welt möglicherweise nicht funktionieren. Die zweite ist, dass es das Symbol-Grundproblem lösen kann, ein philosophisches Problem, dem viele traditionelle KIs begegnen, indem die Sinnesdaten direkt mit sinnvollen Aktionen verknüpft werden. „Der Rückzug der Weltgründe“ und die interne Beziehung der Verhaltensschichten sind direkt in der Welt verankert, die der Roboter wahrnimmt.

Intelligenz – Mit Blick auf den evolutionären Fortschritt argumentiert Brooks, dass das Entwickeln von Wahrnehmungs- und Mobilitätsfähigkeiten eine notwendige Grundlage für eine menschenähnliche Intelligenz ist. Durch die Ablehnung von Top-Down-Darstellungen als realisierbaren Ausgangspunkt für die KI scheint es außerdem so, dass „Intelligenz durch die Dynamik der Interaktion mit der Welt bestimmt wird“.

Entstehung – Konventionell werden einzelne Module von sich aus nicht als intelligent betrachtet. Es ist die Interaktion solcher Module, die durch Beobachtung des Agenten und seiner Umgebung bewertet wird, die normalerweise als intelligent gilt (oder nicht). „Intelligenz“ liegt daher im Auge des Betrachters.

Die oben umrissenen Ideen sind immer noch Teil einer laufenden Debatte über die Art der Intelligenz und darüber, wie der Fortschritt der Robotik und der KI gefördert werden sollte.

Schichten und erweiterte Finite-State-Maschinen

Jede Schicht besteht aus einer Gruppe von Prozessoren, bei denen es sich um erweiterte Finite-State-Machines (AFSM) handelt, wobei der Erweiterung Instanzvariablen hinzugefügt werden, die programmierbare Datenstrukturen enthalten. Eine Ebene ist ein Modul und ist für ein einzelnes Verhaltensziel verantwortlich, z. B. „herumwandern“. Innerhalb oder zwischen diesen Verhaltensmodulen gibt es keine zentrale Kontrolle. Alle AFSMs empfangen kontinuierlich und asynchron Eingaben von den relevanten Sensoren und senden die Ausgabe an Aktuatoren (oder andere AFSMs). Eingangssignale, die bei der Lieferung eines neuen Signals nicht gelesen werden, werden gelöscht. Diese verworfenen Signale sind üblich und für die Leistung nützlich, da das System in Echtzeit arbeiten kann, indem es mit den unmittelbarsten Informationen arbeitet.

Da es keine zentrale Steuerung gibt, kommunizieren AFSMs über Inhibitions- und Unterdrückungssignale miteinander. Sperrsignale blockieren Signale, die Aktuatoren oder AFSMs erreichen, und Unterdrückungssignale blockieren oder ersetzen die Eingänge von Schichten oder deren AFSMs. Dieses System der AFSM-Kommunikation beinhaltet, wie höhere Schichten niedrigere untergliedern (siehe Abbildung 1) und wie die Architektur generell mit Prioritäts- und Aktionsauswahlschlichtung umgeht.

Die Entwicklung von Schichten folgt einem intuitiven Fortschritt. Zuerst wird die unterste Ebene erstellt, getestet und debuggt. Sobald diese unterste Ebene ausgeführt wird, wird die zweite Ebene erstellt und mit den richtigen Unterdrückungs- und Inhibitionsverbindungen an die erste Ebene angefügt. Nach dem Testen und Debuggen des kombinierten Verhaltens kann dieser Vorgang für (theoretisch) beliebig viele Verhaltensmodule wiederholt werden: 16–20

Eigenschaften

In Anbetracht dessen haben die Autoren beschlossen, das Verfahren zu befolgen, das die Grundlage der Subsumtionsarchitektur bildet. Sie befassten sich mit dem Problem, den Roboter vertikal zu erstellen, basierend auf den gewünschten äußeren Ausprägungen des Steuersystems und nicht auf der internen Roboterbetriebsweise. Dann definierten sie sogenannte Kompetenzniveaus. Das Kompetenzniveau ist die Angabe des erforderlichen Niveaus des Roboterverhaltens in Bezug auf alle Umgebungen, in denen sich der Roboter bewegt. Ein höheres Maß an Kompetenz bedeutet ein spezifischeres Verhalten. Der Grundgedanke von Kompetenzniveaus ist, dass es möglich ist, Ebenen eines Steuerungssystems zu erstellen, die einem bestimmten Kompetenzniveau entsprechen, und einfach einer vorhandenen Gruppe eine neue Ebene hinzufügen.

R. Brooks und sein Team definierten 1986 die folgenden Kompetenzniveaus:

Vermeiden Sie den Kontakt mit Gegenständen (egal ob sich diese bewegen oder stillstehen)

1. Erwachen Sie ziellos, ohne mit Objekten in Konflikt zu geraten

2. Erkunden Sie die Welt, indem Sie nach Orten in Reichweite suchen

3. Erstellen Sie eine Umgebungskarte und planen Sie Ihre Reise von einem Ort zum anderen

4. Zeichnen Sie Änderungen in statischen Umgebungen auf

5. Betrachten Sie die Welt in Bezug auf identifizierbare Objekte und führen Sie die mit diesen Objekten verbundenen Aufgaben aus

6. Formulieren und Umsetzen von Plänen, die eine Veränderung des Zustandes der Welt in wünschenswerter Weise erfordern

7. Betrachten Sie das Verhalten von Objekten in der Welt und ändern Sie es entsprechend

Die Autoren bauten zunächst ein komplettes Robotersteuerungssystem, das Null-Level-Kompetenzen erreicht und gründlich hinterfragt. Eine andere Schicht nannte die erste Ebene des Steuersystems. Es ist in der Lage, Daten von der Zero-Schicht des Systems zu verarbeiten, und es ist auch erlaubt, Daten in die internen Zero-Level-Schnittstellen einzufügen, wodurch die normale Bitrate begrenzt wird. Das Prinzip ist, dass die Nullschicht weiterläuft und nichts über die darüber liegende Schicht weiß, was manchmal die Datenpfade stört. Diese Schicht kann mit Hilfe der Nullschicht die Kompetenzen der ersten Stufe erreichen. Der gleiche Prozess wird wiederholt, um ein höheres Kompetenzniveau zu erreichen. Siehe Abbildung 3. Zum Zeitpunkt der Erstellung der ersten Schicht ist bereits ein funktionsfähiger Teil des Steuerungssystems verfügbar. Zusätzliche Ebenen können später hinzugefügt werden und das System kann nicht geändert werden.

Viele ziele

Einzelne Layer können gleichzeitig an einzelnen Zielen arbeiten. Der Unterdrückungsmechanismus vermittelt dann die Aktionen, die berücksichtigt werden. Der Vorteil ist, dass möglicherweise keine vorherige Entscheidung darüber getroffen wird, welches Ziel zu erreichen ist.

Mehrere Sensoren

Alle Sensoren sind möglicherweise nicht Teil einer zentralen Darstellung. Zur zentralen Darstellung kann nur eine Sensoranzeige hinzugefügt werden, die als äußerst zuverlässig erkannt wird. Gleichzeitig können jedoch die Sensorwerte vom Roboter verwendet werden. Andere Ebenen können die Ergebnisse verarbeiten und verwenden, um ihre eigenen Ziele zu erreichen, unabhängig davon, wie mit verschiedenen Ebenen umgegangen wird.

Robustheit

Das Vorhandensein mehrerer Sensoren trägt offensichtlich zur Robustheit des Systems bei, wenn deren Ergebnisse sinnvoll verwendet werden können. In der Subsumtionsarchitektur gibt es eine weitere Robustheit. Bewährte untere Schichten laufen auch dann weiter, wenn höhere Schichten hinzugefügt werden. Da eine höhere Schicht nur durch eine aktive Interferenz mit alternativen Daten die Ausgabe niedrigerer Schichten unterdrücken kann, und in Fällen, in denen sie nicht in geeigneter Weise zu Ergebnissen führen kann, werden niedrigere Werte auch bei einer niedrigeren Kompetenzstufe noch vernünftige Ergebnisse liefern.

Erweiterbarkeit

Ein offensichtlicher Weg, um mit der Skalierbarkeit umzugehen, besteht darin, jede neue Schicht auf einem eigenen Prozessor laufen zu lassen.

Roboter

Im Folgenden finden Sie eine kleine Liste von Robotern, die die Subsumtionsarchitektur verwenden.

Allen (Roboter)

Herbert, ein Getränkedosenroboter

Genghis, ein robuster Hexapodal Walker

Das Obige wird zusammen mit anderen Robotern in Elephants Don’t Play Chess im Detail beschrieben.

Stärken und Schwächen

Die Hauptvorteile der Architektur sind:

die Betonung der iterativen Entwicklung und des Testens von Echtzeitsystemen in ihrem Zielbereich;

die Betonung darauf, eine begrenzte, aufgabenspezifische Wahrnehmung direkt mit den geforderten Handlungen zu verbinden, die dies erfordern; und

die Betonung auf distributive und parallele Kontrolle, wodurch die Wahrnehmungs-, Kontroll- und Aktionssysteme auf ähnliche Weise wie Tiere integriert werden.

Die Hauptnachteile der Architektur sind:

die Schwierigkeit, eine anpassungsfähige Aktionsauswahl durch ein stark verteiltes System der Hemmung und Unterdrückung zu entwerfen;

das Fehlen eines großen Speichers und einer symbolischen Darstellung, die die Architektur anscheinend davon abhalten soll, Sprache zu verstehen;

Als die Subsumtionsarchitektur entwickelt wurde, ermöglichte der neuartige Aufbau und Ansatz der Subsumtionsarchitektur den Erfolg in vielen wichtigen Bereichen, in denen die traditionelle KI versagt hatte, nämlich der Echtzeit-Interaktion mit einer dynamischen Umgebung. Der Mangel an großem Speicher, symbolischen Repräsentationen und zentraler Steuerung macht es jedoch nachteilig, komplexe Aktionen zu erlernen, vertieftes Mapping zu erlernen und Sprache zu verstehen.

Erweiterung

1989 entwickelte Brooks eine Subsumtionsarchitektur, hauptsächlich im Bereich der Eingabebegrenzung und der Unterdrückung von Ausgaben durch endliche Automaten. Im Jahr 1991 kam Brooks mit der Umsetzung des Hormonsystems. Einzelne Schichten sollten durch das Vorhandensein oder Fehlen des Hormons unterdrückt oder eingeschränkt werden. 1992 kommt Mataric auf die Idee einer Architektur, die auf Verhalten basiert. Diese Architektur sollte das Fehlen einer expliziten Darstellung der Welt angehen, ohne an Robustheit und Reaktivität zu verlieren.