O reconhecimento de fala é o sub-campo interdisciplinar da linguística computacional que desenvolve metodologias e tecnologias que permitem o reconhecimento e a tradução da linguagem falada em texto por computadores. Também é conhecido como reconhecimento automático de fala (ASR), reconhecimento de fala por computador ou fala para texto (STT). Ele incorpora conhecimento e pesquisa nos campos de lingüística, ciência da computação e engenharia elétrica.

Alguns sistemas de reconhecimento de fala exigem “treinamento” (também chamado de “inscrição”) em que um falante individual lê texto ou vocabulário isolado no sistema. O sistema analisa a voz específica da pessoa e a utiliza para afinar o reconhecimento da fala dessa pessoa, resultando em maior precisão. Sistemas que não usam treinamento são chamados de sistemas “independentes de alto-falante”. Sistemas que usam treinamento são chamados de “dependentes de alto-falante”.

Aplicativos de reconhecimento de voz incluem interfaces de usuário de voz, como discagem por voz (por exemplo, “Call home”), roteamento de chamadas (por exemplo, “eu gostaria de fazer uma chamada a cobrar”), por exemplo, encontrar um podcast onde palavras específicas foram ditas ), entrada simples de dados (por exemplo, inserção de um número de cartão de crédito), preparação de documentos estruturados (por exemplo, um relatório de radiologia), processamento de fala para texto (por exemplo, processadores de texto ou e-mails) e aeronaves (geralmente denominado entrada de voz direta) .

O termo reconhecimento de voz ou identificação do falante refere-se à identificação do falante, e não ao que ele está dizendo. O reconhecimento do falante pode simplificar a tarefa de traduzir a fala em sistemas que foram treinados em uma voz de uma pessoa específica ou pode ser usado para autenticar ou verificar a identidade de um falante como parte de um processo de segurança.

Do ponto de vista tecnológico, o reconhecimento de fala tem uma longa história com várias ondas de grandes inovações. Mais recentemente, o campo se beneficiou dos avanços em aprendizado profundo e big data. Os avanços são evidenciados não apenas pelo surgimento de trabalhos acadêmicos publicados no campo, mas principalmente pela adoção pela indústria mundial de uma variedade de métodos de aprendizagem profunda para projetar e implantar sistemas de reconhecimento de fala. Esses players da indústria da fala incluem Google, Microsoft, IBM, Baidu, Apple, Amazon, Nuance, SoundHound e iFLYTEK, muitos dos quais divulgaram a tecnologia básica em seus sistemas de reconhecimento de fala como sendo baseada em aprendizado profundo.

Modelos, métodos e algoritmos

Tanto a modelagem acústica quanto a modelagem de linguagem são partes importantes dos modernos algoritmos de reconhecimento de fala baseados em estatística. Os modelos ocultos de Markov (HMMs) são amplamente utilizados em muitos sistemas. A modelagem de linguagem também é usada em muitos outros aplicativos de processamento de linguagem natural, como classificação de documentos ou tradução automática estatística.

Modelos ocultos de Markov

Os modernos sistemas de reconhecimento de fala de propósito geral são baseados em modelos ocultos de Markov. Estes são modelos estatísticos que produzem uma seqüência de símbolos ou quantidades. Os HMMs são usados no reconhecimento de fala porque um sinal de fala pode ser visto como um sinal estacionário por partes ou um sinal estacionário de curta duração. Em uma escala de tempo curta (por exemplo, 10 milissegundos), a fala pode ser aproximada como um processo estacionário. A fala pode ser pensada como um modelo de Markov para muitos propósitos estocásticos.

Outra razão pela qual os HMMs são populares é porque eles podem ser treinados automaticamente e são simples e computacionalmente viáveis de usar. No reconhecimento de fala, o modelo de Markov oculto produziria uma sequência de vetores de valor real n-dimensionais (com n sendo um inteiro pequeno, como 10), emitindo um deles a cada 10 milissegundos. Os vetores consistiriam de coeficientes cepstrais, que são obtidos tomando-se uma transformada de Fourier de uma janela de tempo curto de fala e decorrente da segmentação do espectro usando uma transformada de cosseno, tomando então os primeiros coeficientes (mais significativos). O modelo de Markov oculto tenderá a ter em cada estado uma distribuição estatística que é uma mistura de covariância diagonal gaussiana, o que dará uma probabilidade para cada vetor observado. Cada palavra, ou (para sistemas de reconhecimento de voz mais gerais), cada fonema, terá uma distribuição de saída diferente; Um modelo oculto de Markov para uma seqüência de palavras ou fonemas é feito através da concatenação de modelos de Markov ocultos treinados individualmente para as palavras e fonemas separados.

Descritos acima são os principais elementos da abordagem de reconhecimento de voz mais comum, baseada em HMM. Os sistemas modernos de reconhecimento de fala usam várias combinações de várias técnicas padrão para melhorar os resultados em relação à abordagem básica descrita acima. Um sistema típico de vocabulário grande precisaria de dependência de contexto para os fonemas (assim, fonemas com diferentes contextos esquerdo e direito têm diferentes realizações como estados HMM); usaria normalização cepstral para normalizar para diferentes condições de alto-falante e gravação; para posterior normalização do falante, pode-se usar a normalização do comprimento do trato vocal (VTLN) para a normalização macho-fêmea e a regressão linear de máxima verossimilhança (MLLR) para uma adaptação mais geral do falante. As características teriam os chamados coeficientes delta e delta-delta para capturar a dinâmica da fala e, além disso, poderiam usar a análise discriminante linear heteroscedástica (HLDA); ou pode pular os coeficientes delta e delta-delta e usar splicing e uma projeção baseada em LDA seguida talvez por análise discriminante linear heteroscedástica ou uma transformação de co-variância semidinclinada global (também conhecida como transformada linear de máxima verossimilhança, ou MLLT). Muitos sistemas usam as chamadas técnicas de treinamento discriminativo que dispensam uma abordagem puramente estatística para a estimativa de parâmetros HMM e, em vez disso, otimizam alguma medida relacionada à classificação dos dados de treinamento. Exemplos são informação mútua máxima (MMI), erro mínimo de classificação (MCE) e erro mínimo de telefone (MPE).

A decodificação do discurso (o termo para o que acontece quando o sistema é apresentado com um novo enunciado e deve computar a sentença fonte mais provável) provavelmente usaria o algoritmo Viterbi para encontrar o melhor caminho, e aqui há uma escolha entre criar dinamicamente um combinação de modelo Markov oculto, que inclui tanto as informações acústicas quanto as de modelo de linguagem, e combina-as estaticamente de antemão (a abordagem do transdutor de estado finito, ou FST).

Um possível aprimoramento da decodificação é manter um conjunto de bons candidatos em vez de apenas manter o melhor candidato e usar uma função de pontuação melhor (re pontuação) para classificar esses bons candidatos para que possamos escolher o melhor de acordo com essa pontuação refinada. . O conjunto de candidatos pode ser mantido como uma lista (a abordagem da lista N-best) ou como um subconjunto dos modelos (uma rede). A pontuação é geralmente feita tentando minimizar o risco de Bayes (ou uma aproximação disso): em vez de tomar a sentença de origem com a máxima probabilidade, tentamos tomar a sentença que minimiza a expectativa de uma determinada função de perda em relação a todas as transcrições possíveis. (ie, tomamos a sentença que minimiza a distância média para outras sentenças possíveis ponderadas pela sua probabilidade estimada). A função de perda é geralmente a distância de Levenshtein, embora possa ser distâncias diferentes para tarefas específicas; o conjunto de transcrições possíveis é, obviamente, podado para manter a tratabilidade. Algoritmos eficientes foram desenvolvidos para reescrever redes representadas como transdutores de estado finito ponderados com distâncias de edição representadas por si mesmos como um transdutor de estado finito, verificando certas suposições.

Reconhecimento de voz baseado em Dynamic Time Warping (DTW)

A distorção dinâmica de tempo é uma abordagem que foi usada historicamente para o reconhecimento de fala, mas foi amplamente substituída pela abordagem mais bem-sucedida baseada em HMM.

A distorção temporal dinâmica é um algoritmo para medir a similaridade entre duas sequências que podem variar no tempo ou velocidade. Por exemplo, as semelhanças nos padrões de caminhada seriam detectadas, mesmo se em um vídeo a pessoa estivesse andando devagar e se em outra estivesse caminhando mais rapidamente, ou mesmo se houvesse acelerações e desacelerações no decorrer de uma observação. O DTW foi aplicado a vídeo, áudio e gráficos – de fato, qualquer dado que possa ser transformado em uma representação linear pode ser analisado com o DTW.

Uma aplicação bem conhecida tem sido o reconhecimento automático de voz, para lidar com diferentes velocidades de fala. Em geral, é um método que permite que um computador encontre uma correspondência ideal entre duas sequências dadas (por exemplo, séries temporais) com certas restrições. Ou seja, as sequências são “deformadas” de forma não linear para corresponder umas às outras. Esse método de alinhamento de seqüência é frequentemente usado no contexto de modelos ocultos de Markov.

Redes neurais

As redes neurais surgiram como uma atraente abordagem de modelagem acústica na ASR no final da década de 1980. Desde então, redes neurais têm sido usadas em muitos aspectos do reconhecimento de fala, como classificação de fonemas, reconhecimento de palavras isoladas, reconhecimento de fala audiovisual, reconhecimento de falantes audiovisuais e adaptação de falantes.

Em contraste com os HMMs, as redes neurais não fazem suposições sobre propriedades estatísticas de recursos e possuem várias qualidades, tornando-as modelos de reconhecimento atraentes para reconhecimento de fala. Quando usadas para estimar as probabilidades de um segmento de características de fala, as redes neurais permitem o treinamento discriminativo de maneira natural e eficiente. Poucas suposições sobre as estatísticas dos recursos de entrada são feitas com redes neurais. No entanto, apesar de sua eficácia na classificação de unidades de curta duração, como fonemas individuais e palavras isoladas, as redes neurais raramente são bem-sucedidas para tarefas de reconhecimento contínuo, em grande parte devido à falta de capacidade de modelar dependências temporais.

No entanto, recentemente foram utilizadas Redes Neurais Recorrentes LSTM (RNNs) e Redes Neurais de Atraso Temporário (TDNN’s) que demonstraram ser capazes de identificar dependências temporais latentes e usar essas informações para realizar a tarefa de reconhecimento de fala.

Redes Neurais Profundas e Autoencodificadores Denoising também estavam sendo testados para lidar com este problema de maneira efetiva.

Devido à incapacidade das Redes Neurais de alimentar antecipadamente modelar dependências temporais, uma abordagem alternativa é usar redes neurais como um pré-processamento, por exemplo, transformação de característica, redução de dimensionalidade, para o reconhecimento baseado em HMM.

Redes neurais profundas de feedforward e recorrentes

Uma rede neural feedforward profunda (DNN) é uma rede neural artificial com várias camadas ocultas de unidades entre as camadas de entrada e saída. Semelhante a redes neurais superficiais, os DNNs podem modelar relações não lineares complexas. Arquiteturas DNN geram modelos de composição, onde camadas extras permitem a composição de recursos de camadas inferiores, dando uma enorme capacidade de aprendizagem e, portanto, o potencial de modelagem de padrões complexos de dados de fala.

Um sucesso de DNNs no reconhecimento de fala de vocabulário grande ocorreu em 2010 por pesquisadores industriais, em colaboração com pesquisadores acadêmicos, onde grandes camadas de saída do DNN baseadas em estados HMM dependentes de contexto construídos por árvores de decisão foram adotadas. Veja revisões abrangentes deste desenvolvimento e do estado da arte a partir de outubro de 2014 no recente livro Springer da Microsoft Research. Veja também o contexto relacionado do reconhecimento automático de fala e o impacto de vários paradigmas de aprendizado de máquina, incluindo a aprendizagem profunda em artigos recentes.

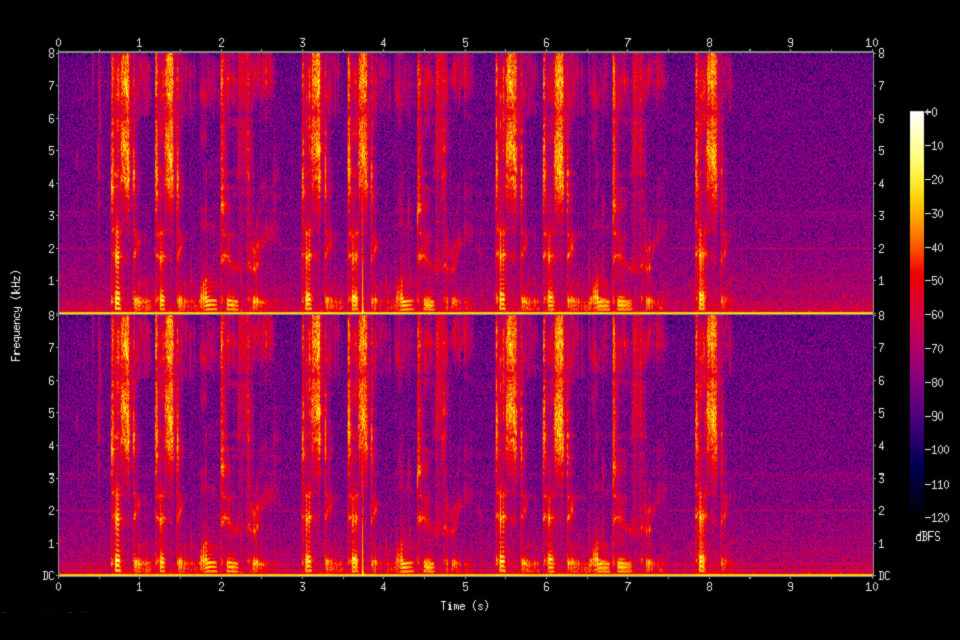

Um princípio fundamental da aprendizagem profunda é eliminar a engenharia de recursos feitos manualmente e usar recursos brutos. Este princípio foi explorado pela primeira vez com sucesso na arquitetura do autoencoder profundo no espectrograma “bruto” ou nas características lineares do banco de filtros, mostrando sua superioridade sobre as características Mel-Cepstral que contêm alguns estágios de transformação fixa a partir de espectrogramas. As verdadeiras características “cruas” da fala, formas de onda, têm mostrado, mais recentemente, produzir excelentes resultados de reconhecimento de fala em larga escala.

Reconhecimento de fala automático de ponta a ponta

Desde 2014, tem havido muito interesse de pesquisa em ASR “end-to-end”. As abordagens tradicionais baseadas em fonética (isto é, em todos os modelos baseados em HMM) exigiam componentes separados e treinamento para o modelo de pronúncia, acústica e linguagem. Modelos end-to-end aprendem conjuntamente todos os componentes do reconhecedor de voz. Isso é valioso, pois simplifica o processo de treinamento e o processo de implantação. Por exemplo, um modelo de linguagem n-gram é necessário para todos os sistemas baseados em HMM, e um modelo típico de linguagem n-gram geralmente leva vários gigabytes de memória, tornando-os impraticáveis para implantação em dispositivos móveis. Conseqüentemente, os modernos sistemas ASR comerciais do Google e da Apple (a partir de 2017) são implantados na nuvem e exigem uma conexão de rede em vez do dispositivo localmente.

A primeira tentativa de ASR end-to-end foi com sistemas baseados na Classificação Temporal (CTC) do Connectionist introduzida por Alex Graves do Google DeepMind e Navdeep Jaitly da Universidade de Toronto em 2014. O modelo consistia em redes neurais recorrentes e uma camada CTC. Em conjunto, o modelo RNN-CTC aprende a pronúncia e o modelo acústico em conjunto, porém é incapaz de aprender a língua devido a pressupostos de independência condicional semelhantes a um HMM. Consequentemente, os modelos de CTC podem aprender diretamente a mapear a acústica da fala para caracteres ingleses, mas os modelos cometem muitos erros de ortografia comuns e devem confiar em um modelo de linguagem separado para limpar as transcrições. Mais tarde, o Baidu expandiu o trabalho com conjuntos de dados extremamente grandes e demonstrou algum sucesso comercial em chinês mandarim e inglês. Em 2016, a Universidade de Oxford apresentou o LipNet, o primeiro modelo de leitura de lábios de ponta a ponta, usando convoluções espaço-temporais acopladas a uma arquitetura RNN-CTC, superando o desempenho em nível humano em um conjunto de dados de gramática restrito.

Uma abordagem alternativa aos modelos baseados em CTC são os modelos baseados em atenção. Modelos de ASR baseados em atenção foram introduzidos simultaneamente por Chan et al. da Carnegie Mellon University e Google Brain e Bahdanaua et al. da Universidade de Montreal em 2016. O modelo chamado “Listen, Attend and Spell” (LAS), literalmente “escuta” o sinal acústico, presta “atenção” a diferentes partes do sinal e “soletra” a transcrição de um caractere de uma vez. Ao contrário dos modelos baseados em CTC, os modelos baseados em atenção não têm suposições de independência condicional e podem aprender diretamente todos os componentes de um reconhecedor de fala, incluindo o modelo de pronúncia, acústico e de linguagem. Isso significa que, durante a implantação, não há necessidade de carregar um modelo de idioma, tornando-o muito prático para implantação em aplicativos com memória limitada. Até o final de 2016, os modelos baseados em atenção obtiveram sucesso considerável, inclusive superando os modelos de CTC (com ou sem um modelo de idioma externo). Várias extensões foram propostas desde o modelo original do LAS. Decomposições de Seqüências Latentes (LSD) foram propostas pela Universidade Carnegie Mellon, MIT e Google Brain para emitir diretamente sub-unidades de palavras que são mais naturais do que caracteres ingleses; A Universidade de Oxford e o Google DeepMind ampliaram o LAS para “Assistir, Ouvir, Assistir e Soletrar” (WLAS) para lidar com a leitura labial superando o desempenho em nível humano.

Aplicações

Sistemas automotivos

Normalmente, uma entrada de controle manual, por exemplo, por meio de um controle de dedo no volante, ativa o sistema de reconhecimento de fala e isso é sinalizado para o motorista por um aviso de áudio. Após o aviso de áudio, o sistema tem uma “janela de escuta”, durante a qual pode aceitar uma entrada de fala para reconhecimento.

Comandos de voz simples podem ser usados para iniciar chamadas telefônicas, selecionar estações de rádio ou reproduzir música de um smartphone compatível, MP3 player ou unidade flash carregada de música. Os recursos de reconhecimento de voz variam entre a marca e o modelo do carro. Alguns dos modelos de carros mais recentes [quando?] Oferecem reconhecimento de fala em linguagem natural no lugar de um conjunto fixo de comandos, permitindo que o driver use sentenças completas e frases comuns. Com tais sistemas, portanto, não há necessidade de o usuário memorizar um conjunto de palavras de comando fixas.

Cuidados de saúde

Documentação médica

No setor de assistência médica, o reconhecimento de fala pode ser implementado no front-end ou back-end do processo de documentação médica. O reconhecimento de fala front-end é onde o provedor determina um mecanismo de reconhecimento de fala, as palavras reconhecidas são exibidas conforme são faladas e o ditador é responsável pela edição e assinatura do documento. O reconhecimento de fala de backend ou diferido é onde o provedor dita em um sistema de ditado digital, a voz é roteada por uma máquina de reconhecimento de fala eo documento de rascunho reconhecido é roteado junto com o arquivo de voz original para o editor, onde o rascunho é editado e relatório finalizado. O reconhecimento de fala diferido é amplamente utilizado na indústria atualmente.

Uma das principais questões relacionadas ao uso do reconhecimento de fala na área da saúde é que a Lei Americana de Recuperação e Reinvestimento de 2009 (ARRA) proporciona benefícios financeiros substanciais aos médicos que utilizam um EMR de acordo com os padrões de “Uso Significativo”. Esses padrões exigem que uma quantidade substancial de dados seja mantida pelo EMR (agora mais comumente referido como um Registro de Saúde Eletrônico ou EHR). O uso do reconhecimento de fala é mais naturalmente adequado à geração de texto narrativo, como parte de uma interpretação radiológica / patológica, nota de progresso ou resumo de descarga: os ganhos ergonômicos do uso do reconhecimento de fala para inserir dados discretos estruturados (por exemplo, valores numéricos ou códigos a partir de uma lista ou de um vocabulário controlado) são relativamente mínimos para pessoas que são avistadas e que podem operar um teclado e um mouse.

Uma questão mais significativa é que a maioria dos EHRs não foi especificamente adaptada para aproveitar os recursos de reconhecimento de voz. Uma grande parte da interação do clínico com o EHR envolve a navegação pela interface do usuário usando menus e cliques de tabulação / botão, e depende muito do teclado e do mouse: a navegação por voz oferece apenas benefícios ergonômicos modestos. Por outro lado, muitos sistemas altamente personalizados para ditado de radiologia ou patologia implementam “macros” de voz, em que o uso de certas frases – por exemplo, “relatório normal” – preenche automaticamente um grande número de valores padrão e / ou gera clichês, variam com o tipo de exame – por exemplo, uma radiografia de tórax versus uma série de contraste gastrointestinal para um sistema de radiologia.

Como uma alternativa a esta navegação à mão, o uso em cascata de reconhecimento de voz e extração de informação tem sido estudado como uma forma de preencher um formulário de entrega para revisão e aprovação clínica. Os resultados são encorajadores e o documento também abre dados, juntamente com os benchmarks de desempenho relacionados e alguns softwares de processamento, para a comunidade de pesquisa e desenvolvimento para o estudo de documentação clínica e processamento de linguagem.

Uso terapêutico

O uso prolongado do software de reconhecimento de fala em conjunto com processadores de texto mostrou benefícios para o restabelecimento da memória de curto prazo em pacientes com MAV do cérebro que foram tratados com ressecção. Mais pesquisas precisam ser conduzidas para determinar os benefícios cognitivos para os indivíduos cujas MAVs foram tratadas usando técnicas radiológicas.

Militares

Aviões de combate de alto desempenho

Esforços substanciais foram dedicados na última década ao teste e avaliação do reconhecimento de fala em aeronaves de combate. Destaca-se o programa norte-americano de reconhecimento de fala para a aeronave AFTI (Advanced Fighter Technology Integration) / F-16 (F-16 VISTA), o programa na França para aeronaves Mirage e outros programas no Reino Unido que tratam de uma variedade. de plataformas de aeronaves. Nesses programas, os reconhecedores de fala foram operados com sucesso em aeronaves de combate, com aplicações que incluem: definir frequências de rádio, comandar um sistema de piloto automático, definir coordenadas de ponto de direção e parâmetros de liberação de armas e controlar a exibição de vôo.

Trabalhando com pilotos suecos voando no cockpit do JAS-39 Gripen, Englund (2004) descobriu que o reconhecimento se deteriorou com o aumento de cargas g. O relatório também concluiu que a adaptação melhorou grandemente os resultados em todos os casos e que a introdução de modelos para respiração mostrou melhorar significativamente as pontuações de reconhecimento. Ao contrário do que se poderia esperar, nenhum efeito do inglês quebrado dos falantes foi encontrado. Era evidente que a fala espontânea causava problemas para o reconhecedor, como era de se esperar. Um vocabulário restrito e, acima de tudo, uma sintaxe adequada, poderia, portanto, melhorar substancialmente a precisão do reconhecimento.

O Eurofighter Typhoon, atualmente em serviço com a RAF do Reino Unido, emprega um sistema dependente de alto-falante, exigindo que cada piloto crie um modelo. O sistema não é usado para tarefas críticas de segurança ou de arma crítica, como liberação de armas ou abaixamento do material rodante, mas é usado para uma ampla gama de outras funções do cockpit. Os comandos de voz são confirmados por feedback visual e / ou auditivo. O sistema é visto como uma característica importante do projeto na redução da carga de trabalho do piloto, e ainda permite que o piloto atribua alvos à sua aeronave com dois simples comandos de voz ou para qualquer um de seus alas com apenas cinco comandos.

Sistemas independentes de alto-falantes também estão sendo desenvolvidos e estão em teste para o F35 Lightning II (JSF) e o treinador de caça líder Alenia Aermacchi M-346 Master. Esses sistemas produziram pontuações de exatidão de palavras superiores a 98%.

Helicópteros

Os problemas de se obter alta precisão de reconhecimento sob estresse e ruído pertencem muito ao ambiente dos helicópteros, bem como ao ambiente dos caças a jato. O problema do ruído acústico é, na verdade, mais severo no ambiente do helicóptero, não apenas devido aos altos níveis de ruído, mas também porque o piloto do helicóptero, em geral, não usa uma máscara facial, o que reduziria o ruído acústico no microfone. Programas substanciais de teste e avaliação foram realizados na última década em aplicações de sistemas de reconhecimento de fala em helicópteros, notadamente pela Atividade de Pesquisa e Desenvolvimento de Aviônicos do Exército dos EUA (AVRADA) e pelo Royal Aerospace Establishment (RAE) no Reino Unido. O trabalho na França incluiu reconhecimento de fala no helicóptero Puma. Também tem havido muito trabalho útil no Canadá. Os resultados foram encorajadores e os aplicativos de voz incluíram: controle de rádios de comunicação, configuração de sistemas de navegação e controle de um sistema automatizado de entrega de alvos.

Como nas aplicações de caça, a questão primordial para a voz em helicópteros é o impacto na eficácia do piloto. Resultados encorajadores são relatados para os testes AVRADA, embora estes representem apenas uma demonstração de viabilidade em um ambiente de teste. Ainda há muito a ser feito tanto no reconhecimento de fala quanto na tecnologia geral de fala para obter consistentemente melhorias de desempenho nos ambientes operacionais.

Formação de controladores de tráfego aéreo

Treinamento para controladores de tráfego aéreo (ATC) representa uma excelente aplicação para sistemas de reconhecimento de fala. Muitos sistemas de treinamento de ATC atualmente exigem que uma pessoa atue como um “pseudo-piloto”, participando de um diálogo de voz com o controlador de treinamento, que simula o diálogo que o controlador teria que conduzir com os pilotos em uma situação ATC real. As técnicas de reconhecimento e síntese de fala oferecem o potencial para eliminar a necessidade de uma pessoa agir como pseudo-piloto, reduzindo assim o treinamento e o pessoal de suporte. Em teoria, as tarefas do controlador aéreo também são caracterizadas por fala altamente estruturada como a saída principal do controlador, portanto, a redução da dificuldade da tarefa de reconhecimento de fala deve ser possível. Na prática, isso raramente é o caso. O documento da FAA 7110.65 detalha as frases que devem ser usadas pelos controladores de tráfego aéreo. Embora este documento ofereça menos de 150 exemplos de tais frases, o número de frases suportadas por um dos sistemas de reconhecimento de fala dos fornecedores de simulação é superior a 500.000.

A USAF, USMC, Exército dos EUA, Marinha dos EUA e FAA, bem como várias organizações internacionais de treinamento ATC, como a Real Força Aérea Australiana e Autoridades de Aviação Civil na Itália, Brasil e Canadá estão atualmente usando simuladores de ATC com reconhecimento de fala. vários fornecedores diferentes.

Telefonia e outros domínios

ASR é agora comum No campo da telefonia, e está se tornando mais difundido no campo de jogos de computador e simulação. Apesar do alto nível de integração com processamento de texto em computação pessoal em geral. No entanto, o ASR no campo da produção de documentos não viu o aumento esperado no uso [por quem?].

A melhoria das velocidades do processador móvel tornou o reconhecimento de fala prático em smartphones. O discurso é usado principalmente como parte de uma interface de usuário, para criar comandos de fala predefinidos ou personalizados. Os principais fornecedores de software neste campo são: Google, Microsoft Corporation (Microsoft Voice Command), Sifão Digital (Sonic Extractor), LumenVox, Nuance Communications (Nuance Voice Control), Tecnologias Voci, Tecnologia VoiceBox, Speech Technology Center, Vito Technologies (VITO Voice2Go ), Speereo Software (Speereo Voice Translator), Verbyx VRX e SVOX.

Uso na educação e no cotidiano

Para o aprendizado de idiomas, o reconhecimento de fala pode ser útil para aprender uma segunda língua. Ele pode ensinar pronúncia adequada, além de ajudar uma pessoa a desenvolver fluência com suas habilidades de fala.

Alunos que são cegos (veja Cegueira e educação) ou têm visão muito baixa podem se beneficiar usando a tecnologia para transmitir palavras e então ouvir o computador recitando-os, bem como usar um computador comandando com a voz, em vez de ter que olhar a tela e o teclado.

Alunos que estão fisicamente incapacitados ou sofrem lesões por esforço repetitivo / outros ferimentos nas extremidades superiores podem ser dispensados de ter que se preocupar com caligrafia, digitação ou trabalho com escriba nas tarefas da escola usando programas de fala para texto. Eles também podem utilizar a tecnologia de reconhecimento de voz para aproveitar livremente a pesquisa na Internet ou o uso de um computador em casa, sem precisar operar fisicamente um mouse e um teclado.

O reconhecimento de fala pode permitir que os alunos com dificuldades de aprendizagem se tornem melhores redatores. Ao dizer as palavras em voz alta, elas podem aumentar a fluidez de sua escrita e ser atenuadas de preocupações em relação à ortografia, pontuação e outras formas de escrita. Além disso, consulte Dificuldades de Aprendizagem.

O uso de software de reconhecimento de voz, em conjunto com um gravador de áudio digital e um computador pessoal que executa o software de processamento de texto, provou ser positivo para restaurar a capacidade danificada de memória de curto prazo, em indivíduos com AVC e craniotomia.

Pessoas com deficiências

Pessoas com deficiência podem se beneficiar de programas de reconhecimento de fala. Para indivíduos surdos ou com deficiência auditiva, o software de reconhecimento de fala é usado para gerar automaticamente uma legenda oculta de conversas, como discussões em salas de conferência, palestras em sala de aula e / ou serviços religiosos.

O reconhecimento de fala também é muito útil para pessoas que têm dificuldade em usar as mãos, variando de lesões leves por esforço repetitivo a envolver deficiências que impedem o uso de dispositivos convencionais de entrada de computador. De fato, as pessoas que usaram muito o teclado e desenvolveram o RSI tornaram-se um mercado urgente para reconhecimento de fala. O reconhecimento de fala é usado em telefonia surda, como correio de voz para texto, serviços de retransmissão e telefone com legenda. Indivíduos com dificuldades de aprendizado que têm problemas com a comunicação do pensamento para o papel (essencialmente pensam em uma idéia, mas é processada incorretamente fazendo com que ela acabe diferentemente no papel) podem se beneficiar do software, mas a tecnologia não é à prova de erros. Também toda a idéia de falar com texto pode ser difícil para pessoas com deficiências intelectuais, devido ao fato de que é raro alguém tentar aprender a tecnologia para ensinar a pessoa com deficiência.

Este tipo de tecnologia pode ajudar as pessoas com dislexia, mas outras deficiências ainda estão em questão. A eficácia do produto é o problema que está impedindo que seja eficaz. Embora uma criança possa dizer uma palavra, dependendo da clareza com que a diz, a tecnologia pode pensar que está dizendo outra palavra e digitar a errada. Dando-lhes mais trabalho para consertar, levando-os a ter mais tempo para consertar a palavra errada.

Outras aplicações

Aeroespacial (por exemplo, exploração espacial, espaçonaves, etc.) A Mars Polar Lander da NASA usou a tecnologia de reconhecimento de voz da Sensory, Inc. no Microfone Mars on the Lander

Legendas automáticas com reconhecimento de fala

Reconhecimento automático de emoções

Tradução automática

Relatório de tribunal (Real Time Speech Writing)

eDiscovery (descoberta legal)

Computação com mãos livres: interface de usuário do computador de reconhecimento de fala

Automação residencial

Resposta de voz interativa

Telefonia móvel, incluindo email móvel

Interação Multimodal

Avaliação de pronúncia em aplicações de aprendizagem de idiomas auxiliada por computador

Legendas em Tempo Real

Robótica

Fala para texto (transcrição do discurso em texto, legendagem de vídeo, reportagem do tribunal)

Telemática (por exemplo, sistemas de navegação de veículos)

Transcrição (fala-para-texto digital)

Jogos de vídeo, com EndWar de Tom Clancy e Lifeline como exemplos de trabalho

Assistente virtual (por exemplo, Siri da Apple)

atuação

O desempenho dos sistemas de reconhecimento de fala é geralmente avaliado em termos de precisão e velocidade. A precisão é geralmente classificada com taxa de erro de palavras (WER), enquanto a velocidade é medida com o fator de tempo real. Outras medidas de precisão incluem Taxa de Erro de Palavra Única (SWER) e Taxa de Sucesso de Comando (CSR).

O reconhecimento de fala por máquina é um problema muito complexo, no entanto. Vocalizações variam em termos de acento, pronúncia, articulação, rugosidade, nasalidade, altura, volume e velocidade. A fala é distorcida por um ruído de fundo e ecos, características elétricas. A precisão do reconhecimento de fala pode variar com o seguinte:

Tamanho do vocabulário e confusabilidade

Dependência do palestrante versus independência

Discurso isolado, descontínuo ou contínuo

Limitações de tarefa e idioma

Ler contra discurso espontâneo

Condições adversas