音声認識は、計算言語学のサブ分野であり、コンピュータによるテキストの認識と翻訳を可能にする方法論と技術を開発しています。 自動音声認識(ASR)、コンピュータの音声認識、またはテキストから音声(STT)としても知られています。 それは、言語学、コンピュータ科学、および電気工学分野における知識と研究を取り入れています。

音声認識システムの中には、個々の話者がテキストや孤立した語彙をシステムに読み込む「トレーニング」(「登録」とも呼ばれる)が必要なものがあります。 システムは、その人の特定の声を分析し、それを使用してその人の声の認識を微調整し、その結果、精度が向上する。 トレーニングを使用しないシステムは、「スピーカーに依存しない」システムと呼ばれます。 トレーニングを使用するシステムは、「スピーカー依存」と呼ばれます。

音声認識アプリケーションには、音声ダイヤル(例:「コールホーム」)、コールルーティング(「収集コールをしたい」など)、ドミトムアプライアンスコントロール、検索(特定の単語が話されたポッドキャストを見つける(例えば、ワードプロセッサまたは電子メール)、および航空機(通常、直接音声入力と呼ばれる)の準備を含むが、これらに限定されるものではない。 。

音声認識または話者識別という用語は、話していることではなく話者を識別することを指します。 話者を認識することで、特定の人の声で訓練されたシステムの音声翻訳作業を簡素化できます。また、セキュリティプロセスの一環として話者の身元を認証または確認するために使用できます。

技術的な観点から言えば、音声認識には長い歴史があり、いくつかの主要なイノベーションの波があります。 最近では、この分野は深い学習と大きなデータの進歩の恩恵を受けています。 この進歩は、現場で発表された学術論文の急増だけでなく、音声認識システムの設計および展開におけるさまざまな深い学習方法の世界的な業界採用によっても証明されています。 これらのスピーチ業界のプレイヤーには、Google、Microsoft、IBM、Baidu、Apple、Amazon、Nuance、SoundHound、iFLYTEKなどがあり、それらの多くは深い学習に基づいた音声認識システムの中核技術を宣伝しています。

モデル、メソッド、アルゴリズム

音響モデリングと言語モデリングの両方が、現代の統計的に基づく音声認識アルゴリズムの重要な部分である。 隠れマルコフモデル(HMM)は、多くのシステムで広く使用されています。 言語モデリングは、文書分類や統計的機械翻訳などの他の多くの自然言語処理アプリケーションでも使用されています。

隠れマルコフモデル

現代の汎用音声認識システムは、隠れマルコフモデルに基づいている。 これらは、一連のシンボルまたは量を出力する統計モデルです。 HMMは、スピーチ信号が区分的な固定信号または短時間の固定信号と見なすことができるため、音声認識に使用される。 短い時間スケール(例えば、10ミリ秒)では、音声は固定的なプロセスとして近似することができる。 音声は、多くの確率的目的のためのマルコフモデルと考えることができる。

HMMが普及しているもう一つの理由は、HMMが自動的に訓練され、使用が簡単で計算上実行可能であるためです。 音声認識では、隠れマルコフモデルはn次元の実数値ベクトルのシーケンス(nは10などの小さな整数)を出力し、これらのうちの1つを10ミリ秒ごとに出力します。 ベクトルは、音声の短時間窓のフーリエ変換を行い、コサイン変換を使用してスペクトルを非相関化し、次に第1(最重要)係数を取ることによって得られるケプストラム係数からなる。 隠れマルコフモデルは、各状態において、観測ベクトルごとに尤度を与える対角共分散ガウス分布の混合である統計的分布を有する傾向がある。 各単語、または(より一般的な音声認識システムの場合)各音素は、異なる出力分布を有する。 単語または音素のシーケンスのための隠れマルコフモデルは、別々の単語および音素のための個々の訓練された隠れマルコフモデルを連結することによって作られる。

上で説明したのは、音声認識に対する最も一般的なHMMベースのアプローチのコア要素である。 現代の音声認識システムは、上述の基本的なアプローチよりも結果を改善するために、いくつかの標準的な技術の様々な組み合わせを使用する。 典型的な大語彙システムは、音素に文脈依存性を必要とする(したがって、左右の文脈が異なる音素は、HMM状態と異なる実現を有する)。 それはケプストラム正規化を使用して、異なる話者および記録条件に対して正規化する。 さらなる話者正規化のために、より一般的な話者適応のために男性 – 女性正規化および最尤線形回帰(MLLR)のために声道長正規化(VTLN)を使用することができる。 これらの特徴は、スピーチダイナミクスを捕捉するためのデルタおよびデルタデルタ係数と呼ばれ、さらに、ヘテロ累進線形判別分析(HLDA)を使用することもある。 デルタおよびデルタデルタ係数をスキップし、恐らく異分散線形判別分析またはグローバル半結合同次変換(最尤線形変換、またはMLLTとしても知られている)に続く、スプライシングおよびLDAベースの投影を使用することができる。 多くのシステムでは、HMMパラメータ推定のための純粋に統計的なアプローチを省略し、その代わりにトレーニングデータの分類関連の測定値を最適化する、いわゆる弁別訓練技術を使用しています。 例としては、最大相互情報量(MMI)、最小分類エラー(MCE)、最小電話エラー(MPE)があります。

スピーチの解読(システムが新しい発言で提示され、最も可能性の高い原文を計算しなければならないときの言葉)は、恐らくビタービアルゴリズムを使用して最良の経路を見つけるだろう。ここでは、音響モデルと言語モデル情報の両方を含み、事前に静的に結合する(有限状態トランスデューサ、すなわちFST、アプローチ)、組み合わされた隠れマルコフモデルである。

デコードを改善するには、最良の候補を保持するのではなく、良い候補のセットを保持し、これらの候補を評価するために、より良いスコアリング関数(再スコアリング)を使用して、この洗練されたスコアに従って最良の候補を選ぶことができます。 候補の集合は、リスト(Nベストリストアプローチ)またはモデルのサブセット(格子)のいずれかとして維持することができる。 再スコアリングは、通常、ベイズのリスク(またはその近似)を最小限に抑えることによって行われます。最大確率で原文を取るのではなく、すべての可能な書き起こしに関する所与の損失関数の期待値を最小にする文を取ろうとします(すなわち、推定された確率で重み付けされた他の可能な文までの平均距離を最小にする文をとる)。 損失関数は、通常、特定のタスクでは異なる距離になる可能性がありますが、通常はレーベンシュタイン距離です。 可能な転写のセットは、もちろん、扱いやすさを維持するために剪定される。 効率的なアルゴリズムは、編集距離を有する加重有限状態変換器として表される再スコア格子が、ある仮定を検証する有限状態変換器として表されるように考案されている。

動的時間ワーピング(DTW)ベースの音声認識

動的時間ワーピングは、音声認識のために歴史的に使用されてきたアプローチであるが、今やHMMベースのアプローチがより成功したことによって主に置き換えられている。

動的時間ワーピングは、時間または速度において変化し得る2つのシーケンス間の類似性を測定するためのアルゴリズムである。 例えば、歩行パターンの類似性は、たとえ1つのビデオで人がゆっくりと歩いていても、別の人が歩行していても、または1つの観察中に加速および減速があったとしても検出される。 DTWはビデオ、オーディオ、グラフィックスに適用されています。実際、線形表現に変換できるデータはDTWで解析できます。

よく知られたアプリケーションは、異なるスピーチスピードに対応するために自動音声認識であった。 一般に、これは、コンピュータが特定の制限を有する2つの所与のシーケンス(例えば、時系列)の間の最適な一致を見つけることを可能にする方法である。 すなわち、シーケンスは互いにマッチするように非線形に「歪められる」。 この配列アライメント方法は、隠れマルコフモデルの文脈でしばしば使用される。

ニューラルネットワーク

ニューラルネットワークは、1980年代後半にASRで魅力的な音響モデリングアプローチとして登場しました。 それ以来、ニューラルネットワークは、音素分類、孤立単語認識、視聴覚音声認識、オーディオビジュアルスピーカ認識、話者適応などの音声認識の多くの側面で使用されてきた。

HMMとは対照的に、ニューラルネットワークは、特徴統計特性について何の仮定もなく、音声認識のための魅力的な認識モデルとなるいくつかの性質を有する。 ニューラルネットワークは、音声特徴セグメントの確率を推定するために使用されるとき、自然かつ効率的な方法で識別的な訓練を可能にする。 ニューラルネットワークでは、入力フィーチャの統計についての前提はほとんどありません。 しかし、個々の音素や孤立した単語などの短時間の単位を分類することの有効性にもかかわらず、ニューラルネットワークは、主に時間依存性をモデル化する能力がないため、継続的な認識作業にはほとんど成功しません。

しかしながら、潜在的な時間依存性を識別し、この情報を音声認識のタスクを実行するために使用できることが示されているLSTMリカレントニューラルネットワーク(RNN)および時間遅延ニューラルネットワーク(TDNN)が最近使用されている。

ディープニューラルネットワークとデノイズオートエンコーダーもこの問題に効果的に取り組むために実験されました。

フィードフォワードニューラルネットワークが時間依存性をモデル化することができないため、代わりのアプローチは、HMMに基づく認識のために、ニューラルネットワークを前処理(例えば、特徴変換、次元削減)として使用することである。

深いフィードフォワードおよびリカレントニューラルネットワーク

深いフィードフォワードニューラルネットワーク(DNN)は、入力層と出力層の間に複数の隠れ層を持つ人工ニューラルネットワークです。 浅いニューラルネットワークと同様に、DNNは複雑な非線形関係をモデル化することができます。 DNNアーキテクチャは、余分なレイヤーが下位レイヤーからのフィーチャーの合成を可能にする構成モデルを生成し、巨大な学習能力を与え、複雑なパターンの音声データをモデリングする可能性を与えます。

意思決定木によって構築された文脈依存HMM状態に基づくDNNの大きな出力層が採用された学術研究者と共同して、大規模語彙音声認識におけるDNNの成功は、産業研究者によって2010年に起こった。 マイクロソフトリサーチのSpringerの最新の本で、この開発と2014年10月現在の最先端技術の包括的なレビューを参照してください。 自動音声認識の関連背景と最近の概説記事で特に深い学習を含む様々な機械学習のパラダイムの影響も参照してください。

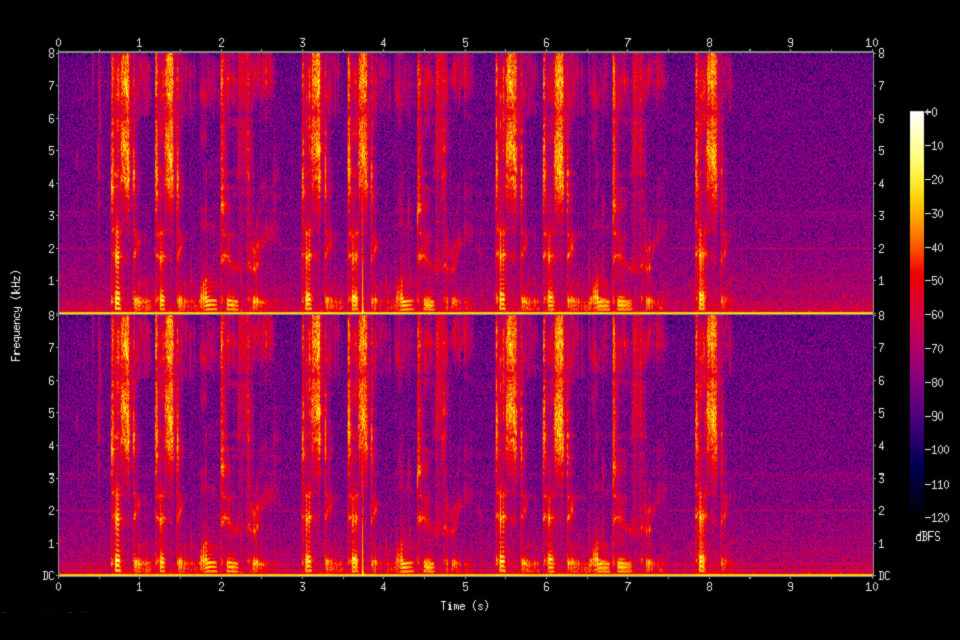

ディープ・ラーニングの基本原理の1つは、手作業のフィーチャー・エンジニアリングを廃止し、生のフィーチャーを使用することです。 この原則は、「生の」スペクトログラムまたは線形フィルタバンクのディープオートエンコーダーのアーキテクチャーで最初に探求され、スペクトログラムから数段階の固定変換を含むMel-Cepstralフィーチャーより優れています。 スピーチの真の「生の」特徴、波形は、最近、優れた大規模な音声認識結果を生み出すことが示されている。

エンドツーエンドの自動音声認識

2014年以降、「エンドツーエンド」ASRに関心が集まっています。 伝統的な音声ベースの(すなわち、すべてのHMMベースのモデル)アプローチでは、発音、音響および言語モデルのための別々のコンポーネントおよびトレーニングが必要でした。 エンドツーエンドモデルは、音声認識装置のすべてのコンポーネントを共同で学習します。 これは、トレーニングプロセスと導入プロセスを簡素化するので有益です。 たとえば、すべてのHMMベースのシステムではnグラム言語モデルが必要であり、典型的なnグラム言語モデルではメモリで数ギガバイトがかかることが多く、モバイルデバイスに展開するには実用的ではありません。 その結果、GoogleやAppleの近代的な商用ASRシステム(2017年現在)がクラウドに導入され、ローカルではなくネットワーク接続が必要になります。

エンドツーエンドASRの最初の試みは、2014年にトロント大学のGoogle DeepMindとNavdeep JaitlyのAlex Gravesによって導入されたConnectionist Temporal Classification(CTC)ベースのシステムでした。モデルはリカレントニューラルネットワークとCTCレイヤーで構成されていました。 共同で、RNN-CTCモデルは発音と音響モデルを一緒に学習するが、HMMと同様の条件付き独立仮定のために言語を学習することはできない。 その結果、CTCモデルは音声音響を英語の文字に直接マッピングすることができますが、モデルは多くの一般的なスペルミスを犯し、別の言語モデルを使用して転写物を整理する必要があります。 その後、Baiduは非常に大規模なデータセットで作業を拡張し、中国語のマンダリン語と英語で商業的成功を収めました。 2016年にオックスフォード大学は、RNN-CTCアーキテクチャと組み合わせた時空畳み込みを使用して、制限された文法データセットで人間レベルのパフォーマンスを上回る最初のエンドツーエンドの文章レベルの唇読みモデルであるLipNetを発表しました。

CTCベースのモデルに対する代替アプローチは、アテンションベースのモデルです。 注意ベースのASRモデルはChanらによって同時に導入された。 カーネギーメロン大学とGoogle Brain and Bahdanaua et al。 “Listen、Attend and Spell”(LAS)という名前のモデルは、文字通り音響信号を “聞き”、信号のさまざまな部分に “注意”を払い、トランスクリプトの1文字を “綴り”ます一度に。 注意ベースのモデルは、CTCベースのモデルとは異なり、条件独立性の仮定を持たず、発音、音響、言語モデルなどの音声認識装置のすべてのコンポーネントを直接学習できます。 これは、展開中に、言語モデルを持ち歩く必要がないことを意味し、メモリが限られたアプリケーションへの展開には非常に実用的です。 2016年末までに、注目ベースモデルは、CTCモデル(外部言語モデルの有無にかかわらず)を上回ることを含め、かなりの成果を収めました。 元のLASモデルから様々な拡張が提案されている。 Carnegie Mellon University、MIT、Google Brainは潜在的なシーケンス分解(LSD)を提案し、英語の文字よりも自然なサブワード単位を直接生成しました。 オックスフォード大学とGoogle DeepMindは、人間レベルのパフォーマンスを上回る唇の読みを処理するためにLASを「見る、聞く、出席する、綴る」(WLAS)に拡張しました。

アプリケーション

車載システム

典型的には、ステアリングホイールの指の制御などによる手動制御入力は音声認識システムを可能にし、これは音声プロンプトによって運転手に知らされる。 オーディオプロンプトに続いて、システムは認識のための音声入力を受け入れることができる「リスニングウィンドウ」を有する。

シンプルな音声コマンドを使用して電話をかけたり、ラジオ局を選択したり、互換性のあるスマートフォン、MP3プレーヤーまたは音楽読み込み式フラッシュドライブから音楽を再生することができます。 音声認識能力は車種とモデルによって異なります。 最新の[when?]カーモデルの一部は、固定されたコマンドセットの代わりに自然言語の音声認識を提供し、ドライバが完全な文章および共通のフレーズを使用できるようにします。 したがって、このようなシステムでは、ユーザが一組の固定されたコマンド語を覚える必要はない。

健康管理

医療文書

ヘルスケア部門では、音声認識は医療文書作成プロセスのフロントエンドまたはバックエンドで実装できます。 フロントエンドの音声認識とは、プロバイダが音声認識エンジンを指示し、認識された単語が話されると表示され、独裁者が文書の編集やサインオフを担当する場所です。 バックエンド音声認識または遅延音声認識は、プロバイダがデジタル音声認識システムに指示し、音声が音声認識マシンを介してルーティングされ、認識されたドラフト文書が元の音声ファイルとともにエディタにルーティングされ、ドラフトが編集される報告書が完成しました。 遅延音声認識は、現在業界で広く使用されている。

医療における音声認識の使用に関連する主要な問題の1つは、2009年の米国復興と再投資法(ARRA)が、「意味ある使用」基準に従ってEMRを利用する医師に多大な金銭的利益をもたらすことである。 これらの基準では、EMR(現在はより一般的に電子健康記録またはEHRと呼ばれている)によって相当量のデータが維持されることが求められています。 音声認識の使用は、放射線学/病理学の解釈、進行メモまたは放電の要約の一部としてのナラティブテキストの生成に、より自然に適している:音声認識を使用して構造化離散データ(例えば、数値またはコードリストまたは制御された語彙からの)は、目に見え、キーボードおよびマウスを操作することができる人に対しては、比較的最小限である。

より重要な問題は、ほとんどのEHRが音声認識機能を利用するように明示的に調整されていないことです。 医師のEHRとの対話の大部分は、メニューとタブ/ボタンのクリックを使用したユーザーインターフェイスのナビゲーションであり、キーボードとマウスに大きく依存しています。音声ベースのナビゲーションは人間工学にはあまり役立ちません。 対照的に、放射線医学または病理学のディクテーション用の高度にカスタマイズされたシステムの多くは、特定のフレーズ(例えば、「通常の報告」)の使用が自動的に多数のデフォルト値を記入し、および/または定型文を生成する音声「マクロ検査の種類によって異なります。例えば、胸部X線と放射線学システムの胃腸コントラストシリーズです。

手作業によるこのナビゲーションの代わりに、臨床校正とサインオフのためのハンドオーバー形式を記入する方法として、音声認識と情報抽出のカスケード型の使用が検討されています。 結果は励みになります。また、関連するパフォーマンスベンチマークといくつかの処理ソフトウェアとともに、臨床ドキュメントと言語処理を研究するための研究開発コミュニティにデータを公開しています。

治療上の使用

ワードプロセッサと音声認識ソフトウェアの長期使用は、切除治療を受けた脳AVM患者の短期記憶の回復に利点を示しています。 AVMが放射線技法を用いて治療されている個体の認知的利益を決定するためには、さらなる研究が必要である。

軍隊

高性能戦闘機

過去10年間に、戦闘機における音声認識のテストと評価に多大な努力が払われてきた。 特に、AFTI(Advanced Fighter Technology Integration)/ F-16(F-16 VISTA)航空機、ミラージュ航空機向けフランスのプログラム、その他の多様性を扱う英国のプログラムでは、米国のプログラムが注目されています航空機プラットフォームの これらのプログラムでは、無線周波数の設定、オートパイロットシステムの指令、ステアポイント座標と武器解放パラメータの設定、飛行の表示の制御などのアプリケーションを含む、音声認識装置が戦闘機でうまく動作しています。

Englund(2004)は、JAS-39 Gripenの操縦席を操縦しているスウェーデンのパイロットと協力して、g荷重が増加するにつれて認識率が低下することを発見しました。 また、適応はすべての症例において結果を大きく改善し、呼吸モデルの導入は認識スコアを有意に改善することが示された。 予想されたこととは反対に、スピーカーの壊れた英語の影響は見られませんでした。 予期されたように、自発的な発言が認識装置にとって問題を引き起こしたことは明らかであった。 制限された語彙、とりわけ適切な構文は、認識精度を大幅に向上させることが期待できる。

現在英国RAFと協力しているEurofighter Typhoonは、スピーカー依存のシステムを採用しており、各パイロットにテンプレートを作成する必要があります。 このシステムは、武器の解放や貨物の降下などの安全上重要な作業や兵器に不可欠な作業には使用されませんが、他のさまざまな操縦席機能に使用されます。 音声コマンドは、視覚および/または聴覚フィードバックによって確認される。 このシステムは、パイロットの作業負荷を軽減するための主要な設計上の特徴であり、パイロットは2つの簡単な音声コマンドで航空機に目標を割り当てることさえできます。

スピーカーに依存しないシステムも開発されており、F35 Lightning II(JSF)とAlenia Aermacchi M-346マスター・リードイン・ファイター・トレーナーのテスト中です。 これらのシステムでは、単語精度スコアが98%を超えています。

ヘリコプター

ストレスとノイズのもとで高い認識精度を達成する問題は、ヘリコプター環境及びジェット戦闘機環境に強く関係する。 アコースティックノイズの問題は、実際にはヘリコプター環境においてより深刻であり、高い騒音レベルのためだけでなく、ヘリコプターパイロットは一般に、マイクロフォンの音響ノイズを低減するフェイスマスクを着用しないためである。 実質的なテストと評価プログラムは、過去10年間、ヘリコプターの音声認識システムのアプリケーション、特に米国陸軍航空宇宙研究開発活動(AVRADA)とイギリスのRAE(Royal Aerospace Establishment)によって実施されました。 フランスでの仕事には、プーマヘリコプターでの音声認識が含まれています。 カナダでも多くの有益な仕事がありました。 結果は奨励されており、音声アプリケーションには、通信ラジオの制御、ナビゲーションシステムの設定、自動ターゲットハンドオーバーシステムの制御が含まれています。

戦闘機のアプリケーションと同様に、ヘリコプターにおける音声の優先課題はパイロットの有効性への影響です。 AVRADAテストの結果は、テスト環境での実現可能性のデモンストレーションにすぎませんが、奨励結果は報告されています。 動作設定における性能向上を一貫して達成するためには、音声認識と全体的なスピーチ技術の両方において多くのことが行われている。

航空管制官の訓練

航空交通管制官(ATC)のトレーニングは、音声認識システムの優れたアプリケーションです。 多くのATC訓練システムは現在、擬似パイロットとして行動する必要があり、実際のATC状況で操縦士が行うべき対話をシミュレートする訓練士のコントローラとの音声対話を行う。 音声認識および合成技術は、人が疑似パイロットとして行動する必要性を排除する可能性を提供し、トレーニングおよびサポート要員を削減する。 理論的には、エアコントローラのタスクは、コントローラの主要な出力として高度に構造化されたスピーチを特徴とするため、スピーチ認識タスクの難しさを軽減することが可能でなければなりません。 実際には、これはまれです。 FAA文書7110.65には、航空管制官が使用すべきフレーズが詳述されている。 この文書ではこのようなフレーズの例が150件未満ですが、シミュレーションベンダーの音声認識システムでサポートされているフレーズの数は50万を超えています。

USAF、USMC、米国陸軍、米海軍、FAA、およびイタリア、ブラジル、カナダのRoyal Australian Air ForceやCivil Aviation Authoritiesなどの多くの国際ATC訓練機関では、現在ATCシミュレータを使用しています。いくつかの異なるベンダー。

テレフォニーおよびその他のドメイン

ASRは現在、電話の分野では一般的であり、コンピュータゲームおよびシミュレーションの分野でより広範になりつつあります。 一般的なパーソナルコンピューティングにおけるワードプロセッシングとの高度な統合にもかかわらず、 しかし、ASRのドキュメント制作分野では、誰が使用するのが期待されていないのでしょうか?

モバイルプロセッサのスピードの向上により、スマートフォンでは音声認識が実用的になりました。 音声は、あらかじめ定義された音声コマンドまたはカスタム音声コマンドを作成するために、主にユーザーインターフェイスの一部として使用されます。 この分野の主要なソフトウェアベンダーは、Google、Microsoft Corporation(Microsoft Voice Command)、Digital Siphon(Sonic Extractor)、LumenVox、ニュアンスコミュニケーション(Nuance Voice Control)、Voci Technologies、VoiceBoxテクノロジー、スピーチテクノロジーセンター、Vito Technologies(VITO Voice2Go )、Speereoソフトウェア(Speereo Voice Translator)、Verbyx VRXおよびSVOX。

教育と日常生活での使用

言語学習のために、音声認識は第2言語の学習に役立ちます。 適切な発音を教えることができます。さらに、スピーチスキルを身につけた人の流暢さを高めるのに役立ちます。

視覚障害(視覚障害および教育を参照)または非常に低い視力を有する学生は、この技術を使用して単語を伝え、コンピュータがそれらを暗唱するのを聞くだけでなく、見ることなく音声で命令することによってコンピュータを使用することで利益を得ることができますスクリーンとキーボード。

物理的に身体障害があるか、上肢の重篤な怪我/その他の怪我に悩まされている生徒は、スピーチ・トゥ・テキスト・プログラムを使用して、筆記、タイピング、または筆記作業を心配する必要がなくなります。 また、音声認識技術を利用して、マウスやキーボードを物理的に操作することなく、インターネットでの検索や自宅のコンピュータを自由に楽しむことができます。

音声認識により、学習障害を持つ生徒はより良い作家になれる。 言葉を大声で言うことによって、彼らは文章の流動性を高め、スペル、句読点、およびその他の文章の仕組みに関する懸念を緩和することができます。 また、「学習障害」を参照してください。

音声認識ソフトウェアの使用は、デジタルオーディオレコーダーおよびワープロソフトウェアを実行しているパーソナルコンピュータと連携して、脳卒中および開頭術の個人の損傷した短期記憶容量を回復することに肯定的であることが証明されている。

障害を持つ人々

障害を持つ人々は、音声認識プログラムの恩恵を受けることができます。 聴覚障害者または難聴者の場合、音声認識ソフトウェアを使用して、会議室でのディスカッション、教室での講義、および/または宗教的サービスなどの字幕を自動的に生成します。

スピーチ認識は、軽度の反復ストレス傷害から従来のコンピュータ入力装置の使用を妨げる障害に至るまで、手を使用することが困難な人々にとっても非常に有用である。 実際、キーボードを多く使い、RSIを開発した人々は、スピーチ認識のための早急な市場となりました。 音声認識は、ボイスメールからテキスト、中継サービス、字幕付き電話などの聴覚障害者の電話で使用されます。 紙に書かれたコミュニケーションに問題がある(本質的に彼らはアイデアを考えていますが、誤って処理されて別の紙になる可能性があります)、ソフトウェアの恩恵を受ける可能性がありますが、その技術はバグの証拠ではありません。 また、誰もが障害のある人を教えるための技術を習得しようとすることはまれであるという事実のため、知的障害者のためにテキストを話すというアイデアは難しいかもしれません。

このタイプの技術は、失読症の人を助けることができますが、他の障害はまだ問題です。 製品の有効性は、それが効果的であることを妨げている問題です。 子供はどれほど明確であるかに応じて言葉を言うことができるかもしれないが、技術は彼らが別の言葉を言って、間違った言葉を入力していると思うかもしれない。 彼らに修正のための仕事を与えて、間違った言葉を修正して時間を取らなければならなくなりました。

さらなるアプリケーション

航空宇宙(宇宙探査、宇宙船など)NASAの火星Polar LanderはSensory、Inc.のスピーチ認識技術を火星のマイクロフォンで使用しました

音声認識による自動字幕作成

自動感情認識

自動翻訳

裁判所の報告(リアルタイムの音声筆記)

eDiscovery(法的発見)

ハンズフリーコンピューティング:音声認識コンピュータのユーザインタフェース

ホームオートメーション

インタラクティブな音声応答

モバイル電子メールを含むモバイル電話

マルチモーダル対話

コンピュータ支援言語学習アプリケーションにおける発音評価

リアルタイムキャプション

ロボット工学

音声をテキストに変換する(音声をテキストに変換する、ビデオキャプション、裁判所の報告)

テレマティクス(例:車両ナビゲーションシステム)

転写(デジタル音声 – テキスト)

Tom ClancyのEndWarとLifelineを使用したビデオゲームの実例

バーチャルアシスタント(AppleのSiriなど)

パフォーマンス

音声認識システムの性能は、通常、精度とスピードの点で評価されます。 精度は通常、ワードエラーレート(WER)で評価されますが、速度は実時間係数で測定されます。 他の正確度の尺度には、シングルワード誤り率(SWER)およびコマンド成功率(CSR)が含まれる。

しかしながら、機械による音声認識は非常に複雑な問題である。 発声は、アクセント、発音、アーティキュレーション、ラフネス、ナーシリアリティ、ピッチ、音量、スピードの点で異なります。 音声は背景雑音とエコー、電気的特性によって歪められる。 音声認識の精度は、次のように異なる場合があります。

語彙のサイズと混乱の可能性

スピーカーの依存性と独立性

断絶された、不連続な、または連続的なスピーチ

タスクと言語の制約

読解対自然発話

悪条件