感情認識は、人間の感情を識別するプロセスであり、最も典型的には、表情だけでなく言葉による表現でもあります。 これは、人間が自動的に行うことの両方であるが、計算方法論も開発されている。

科学的定義感情

感情は感情、気分、人格の概念と区別しなければならない。 感情はたとえば、壁の後ろにマスクされた人がいると感じると恐れます。 それからあなたは恐怖を感じる。 この身体的変化が認知的に評価されるとき、感情は感情になるだけです。

例えば、誰かが仮面舞踏会の男に戻ってきたとすると、恐怖が語られます。 しかし、彼が秘密に愛する人に戻ると、喜びを語るでしょう。 感情は通常わずか数秒間持続し、オンセットとオフセットが明確に定義されています。 一方、気分は数時間、数日または数週間続くことがあります。 誰かが今日彼が気分が悪いと言ったら、彼は気分が悪いです。 しかし、これは必ずしも感情とは関係ありません。

しばしば、特定の気分は、特定の感情の発生確率を増減させることができるが、これら2つのことは分析的に分離されなければならない。 最後に、人の性格は気分と区別する必要があります。 例えば、卑劣な人は永久に否定的に過度に興奮している。 このようにして、感情、感情、気分、性格という言葉がタイムライン上に配置されていると想像することができます。一方では気持ちが短く、他方では人格、長期的には人格です。

人間

人間は感情を認識することにおいて普遍的な一貫性を示すだけでなく、能力の個人間で大きな変動性を示す。 これは心理学における重要な研究テーマです。

クロスレースの効果

2人の間の感情的な認識は強い変動の対象となる。 心理学では、クロスレース効果と呼ばれる現象が発見されました。 この現象は、認識される感情が、観察者と同じ文化や民族に属さない顔に属する場合、感情認識率が低下することを意味する。 しかし、この効果は一種の訓練によって克服することができます。

ビジュアル模倣認識

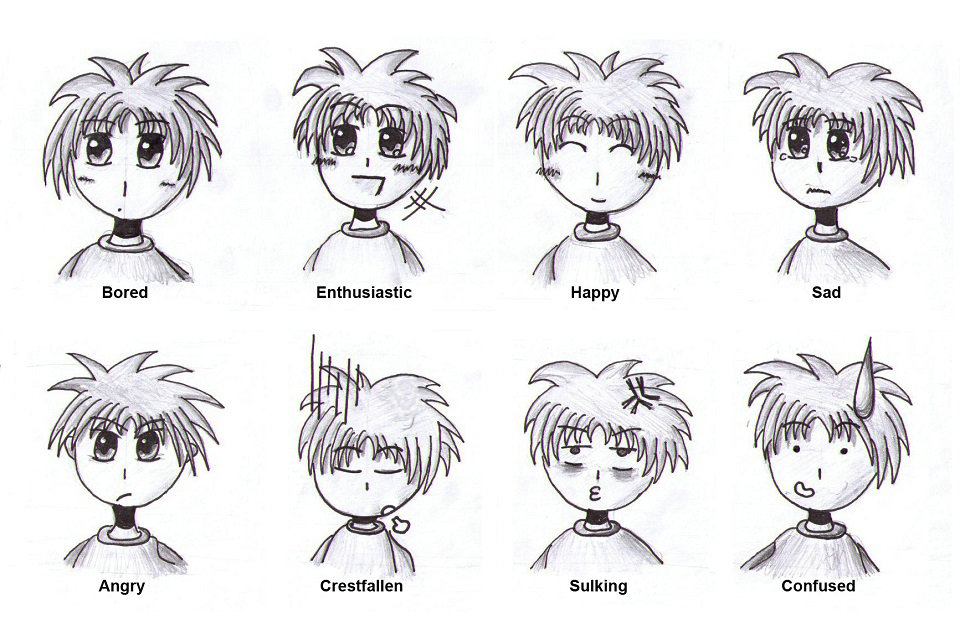

この部分は、通常、表情と呼ばれます。 ヒューマンマシンインターフェースとして、デジタルビデオカメラまたは同等の光入力装置が使用される。 ここで、顔認識の方法は、顔面の特徴を分析するために使用される。 自動分類によって、連続フレームの表情を、感情に関連する可能性のあるクラスタと関連付けることが可能である。 しかし、模倣感情の30%だけが本当に感じる感情に対応していることが研究によって示されています。 したがって、視覚的な表情と視覚的な感情認識を一致させるべきではありません。 視覚的感情認識の生物学的背景は、ロボットにおける人間の視神経のシミュレーションである。

感情誘発

感情心理学、行動学的研究、神経心理学および他の多くの科学の分野における実験的設定のために、実験室条件下で特定の感情を「生成する」ことがしばしば重要である。 感情誘導は、感情研究の最も難しい分野の1つです。 このトピックに関するいくつかのメタ分析は、感情を最も効果的に誘導することができるいくつかの方法を抽出した。

まず第一に、現実感の捉え方(キーワードフィールド研究)です。 内部の妥当性が低いため、これはしばしば控えています。 第2の方法は、高い内的効果と高い外的妥当性を組み合わせる方法であり、感情記憶から記憶を呼び起こそうとする感情的リコールの方法である。 脳波感情研究以外の実験では、感情誘導のフィルムシーケンスや楽曲を使用するIAPSや誘導方法などの誘導方法による研究はお勧めしません。 これらの方法はすべて、特定の有効性を証明するものではありません。 ロボット工学者は、理想化された実験手順、

誘導法は人間の感情を誘発すると考えられている。

男は顔の表情が変わった彼の感情を表現する。

コンピュータ上のWebカメラが新しい表情をキャプチャします。

コンピュータは、以前に誘発された感情として分類することによって、感情を自動的に分類することができる。

学習段階を完了した後、AIは、以前に人間によって教えられていなくても、独立して感情を認識することができるはずである。 しかしながら、誘発法はしばしば有効性について試験されておらず、実験自体の間に誘発された感情も評価されないので、ロボット工学におけるこれらの理想化された実験手順はしばしば誤ったままであり、不完全である。

自動

このプロセスは、信号処理、機械学習、コンピュータビジョンなど、複数の分野の技術を活用します。 ベイジアンネットワーク、ガウス混合モデルおよび隠れマルコフモデルのような感情を解釈するために、異なる方法論および技法を使用することができる。

アプローチ

感情認識の課題は、テキスト、オーディオ、ビデオなどのマルチモーダル形式の人間の表現を分析することがよくあります。 顔の表情、身体の動きとジェスチャー、および音声からの情報の統合によって、異なる感情タイプが検出されます。 特定の感情タイプを分類するための感情認識における既存のアプローチは、一般に、知識ベース技術、統計手法、およびハイブリッド手法の3つの主なカテゴリに分類することができる。

知識ベースのテクニック

知識ベースのテクニック(レキシコンベースのテクニックと呼ばれることもある)は、特定の感情タイプを検出するために、ドメイン知識と言語の意味論的および構文的特性を利用する。 このアプローチでは、WordNet、SenticNet、ConceptNet、EmotiNetなどの感情分類プロセスで知識ベースのリソースを使用するのが一般的です。 このアプローチの利点の1つは、そのような知識ベースのリソースの可用性が高いことによってもたらされるアクセシビリティと経済性です。 一方、この手法の限界は、概念のニュアンスや複雑な言語的ルールを扱うことができないことです。

知識ベースの手法は、主に辞書ベースのアプローチとコーパスベースのアプローチの2つのカテゴリに分類することができます。 辞書ベースのアプローチでは、意見や感情のシード単語を辞書に入れて、同義語や反意語を検索して、意見や感情の最初のリストを広げます。 一方、コーパスベースのアプローチは、意見や感情語の種別リストから始まり、大規模なコーパス内の文脈特有の特徴を有する他の単語を見つけることによってデータベースを拡張する。 コーパスベースのアプローチではコンテキストを考慮していますが、1つのドメイン内の単語が別のドメイン内の異なる方向を持つ可能性があるため、ドメインごとにパフォーマンスは変わります。

統計的方法

統計的方法は、一般に、システムが様々な感情タイプを学習し、予測するために、大きなセットの注釈付きデータがアルゴリズムに入力される、異なる教師付き機械学習アルゴリズムの使用を含む。 このアプローチは、通常、トレーニングセットとテストセットの2つのデータセットを含みます。トレーニングセットとテストセットは、データの属性を学習するために使用され、後者は、機械学習アルゴリズムのパフォーマンスを検証するために使用されます。 機械学習アルゴリズムは、一般に、他のアプローチと比較してより合理的な分類精度を提供するが、分類プロセスにおいて良好な結果を達成する上での課題の1つは、十分に大きなトレーニングセットを有する必要があることである。

最も一般的に使用される機械学習アルゴリズムには、SVM(Support Vector Machines)、Naive Bayes、Maximum Entropyなどがあります。 監督されていない機械学習の下にある深い学習は、感情認識にも広く採用されています。 よく知られている深い学習アルゴリズムには、CNN(Convolutional Neural Network)、LSTM(Long Short-Term Memory)、ELM(Extreme Learning Machine)などの人工ニューラルネットワーク(ANN)のさまざまなアーキテクチャが含まれます。 感情認識の分野における深い学習アプローチの人気は、主にコンピュータビジョン、音声認識、自然言語処理(NLP)などの関連アプリケーションの成功に起因する可能性があります。

ハイブリッドアプローチ

感情認識におけるハイブリッドアプローチは、本質的に、両方の技術の相補的な特性を利用する知識ベースの手法と統計的手法との組み合わせである。 知識駆動型言語要素と統計的方法のアンサンブルを適用した作品には、概念コンピューティングとiFeelがあり、いずれも概念レベルの知識ベースのSenticNetリソースを採用しています。 ハイブリッドアプローチの実施におけるそのような知識ベースのリソースの役割は、感情分類プロセスにおいて非常に重要である。 ハイブリッド技術は、知識ベースアプローチと統計アプローチの両方によって提供される利点から利益を得るため、知識ベースまたは統計的手法を独立して使用するのではなく、より優れた分類パフォーマンスを持つ傾向があります。 しかしながら、ハイブリッド技術を使用することの欠点は、分類プロセス中の計算上の複雑さである。

データセット

データは、感情認識における既存のアプローチの不可欠な部分であり、ほとんどの場合、機械学習アルゴリズムを訓練するために必要な注釈付きデータを得ることは難しい課題です。 一般に公開されているデータには注釈が付されていませんが、感情認識研究を行うための既存の注釈付きデータセットがあります。 テキスト、オーディオ、ビデオ、または生理学的信号の形でマルチモーダルソースから異なる感情タイプを分類するタスクのために、以下のデータセットが利用可能である:

HUMAINE:複数のモダリティで感情語と文脈ラベルを持つ自然なクリップを提供

ベルファストデータベース:テレビ番組やインタビュー録画からの幅広い感情をクリップに提供する

SEMAINE:人と仮想エージェントの間に視聴覚記録を提供し、怒り、幸せ、恐怖、嫌悪感、悲しみ、軽蔑、娯楽などの感情の注釈を含みます

IEMOCAP:俳優間のダイアディックセッションの記録を提供し、幸福、怒り、悲しみ、欲求不満、中立状態などの感情注釈を含む

eNTERFACE:7つの国籍の被験者の視聴覚記録を提供し、幸福感、怒り、悲しみ、驚き、嫌悪感、恐怖などの感情の注釈を含みます

DEAP:脳波(EEG)、心電図(ECG)、顔のビデオ録音、感情注釈を原子価、覚醒、映画クリップを視聴している人々の支配の観点から提供する

DREAMER:脳波を鑑賞する人々の価数、覚醒、支配の観点から、脳波記録(EEG)と心電図(ECG)記録、感情注釈を提供する

アプリケーション

コンピュータプログラマーは、多くの場合、Paul EkmanのFacial Action Coding Systemをガイドとして使用します。

感情認識は、さまざまな理由で使用されます。 Affectivaは、広告主とコンテンツクリエイターが製品をより効果的に販売するのに役立ちます。 Affectivaはまた、自閉症児の感情を測定するQセンサーを作る。 Emotientは、人工知能を利用して「表情に基づく態度や行動」を予測するスタートアップ企業でした。 Appleは2016年1月にEmotientを購入する意向を示しました.nVisoは、リアルタイムAPIを通じてWebおよびモバイルアプリケーションのリアルタイム感情認識を提供します。 Visage Technologies社はマーケティングや科学研究などの目的でVisage SDKの一部として感情推定を提供しています。 アイエリスは、自動車メーカーや社会ロボット企業などの組込みシステムメーカーと顔分析と感情認識ソフトウェアを統合して動作する感情認識会社です。 ビデオコンテンツクリエイターと協力して、短くて長い形式のビデオクリエイティブの認識された効果を測定するのに役立ちます。 感情認識と感情分析は世界中の企業や大学で研究されています。

嘘発見

多感情感情知覚は、発話の真実性を評価する上で、より具体的には、偽りを検出する際に役立ちます。嘘は意図的に誤った欺瞞的な発言と理解されるべきです。 偽り、擬態、身振り、言葉や姿勢の確からしさについて普遍的に有効な指標ではありませんが、手がかりを得ることができます。 相対的に信頼できるのは、瞳孔の幅、視線、または白斑などの、無意識または制御不能な信号です。 さらに、人の様々な口頭表現と非言語表現との間の相違に注目すべきである。