Videosynthesizer

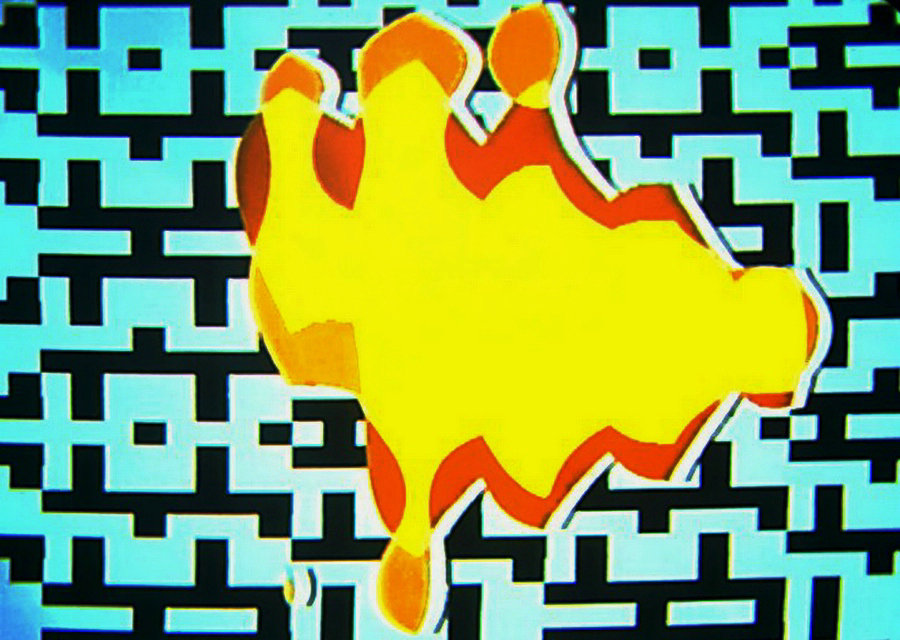

Ein Videosynthesizer ist ein Gerät, das elektronisch ein Videosignal erzeugt. Ein Videosynthesizer kann mithilfe interner Videomustergeneratoren eine Vielzahl von Bildmaterial ohne Kameraeingabe erzeugen. Es kann auch Live-Fernsehkamerabilder akzeptieren und „bereinigen und verbessern“ oder „verzerren“. Der Synthesizer erzeugt durch rein elektronische Manipulationen eine breite Palette von Bildern. Diese Bilder sind im Ausgangsvideosignal sichtbar, wenn dieses Signal angezeigt wird. Das ausgegebene Videosignal kann auf einer Vielzahl herkömmlicher Videogeräte wie Fernsehmonitoren, Theatervideoprojektoren, Computerbildschirmen usw. angezeigt werden.

Für die Erzeugung selbst wird kein Computer oder keine Kamera benötigt, das Signal wird vollständig von Grund auf neu erstellt und das Ausgangssignal ist häufig analog. Daher ist das Medium, auf dem das Bild angezeigt werden kann, begrenzt. CRT-Bildschirme oder Projektoren werden normalerweise verwendet, weil das Videosignal so stark verändert wird, dass es von einem digitalen Standardgerät als beschädigt bewertet wird und nichts anzeigt.

Es ist nicht ungewöhnlich, dass einige Videosynthesizer durch Modifizieren alter Videoprozessoren erstellt werden, mit denen analoge Videos bereinigt wurden. Diese Umwandlung beinhaltet ein sogenanntes Schaltungsbiegen, bei dem die Schaltungen der Vorrichtung selbst modifiziert werden, beispielsweise durch Hinzufügen eines Schalters zwischen zuvor geteilten Schaltungsschaltungen. Andere Modifikationen können das Hinzufügen von Potentiometern oder Fotowiderständen sein.

Videomustergeneratoren können statische oder sich bewegende oder sich entwickelnde Bilder erzeugen. Beispiele hierfür sind geometrische Muster (in 2D oder 3D), Untertitel-Textzeichen in einer bestimmten Schriftart oder Wetterkarten.

Bilder von Fernsehkameras können farblich verändert oder geometrisch skaliert, gekippt, um Objekte gewickelt und auf andere Weise manipuliert werden.

Ein bestimmter Videosynthesizer bietet eine Teilmenge möglicher Effekte.

Die Videosynthese kann auch als Modifikation eines Audiosignals zum Zweck der Projektion auf ein Oszilloskop betrachtet werden, das beispielsweise von Jerobeam Fenderson in seinem Projekt Oscilloscope Music verwendet wurde. Das Videosignal (oder seine Unterordner) kann häufig durch ein Audiosignal moduliert werden, das zusammen mit der Möglichkeit, in Echtzeit zu arbeiten, seine Anwendung in VJing in Clubs, Konzerten oder anderen Aufführungen gefunden hat.

Videosynthesizer als Echtzeit-Performance-Instrumente

Die Geschichte der Videosynthese ist an eine „Echtzeit-Performance“ -Ethik gebunden. Es wird normalerweise erwartet, dass das Gerät mit Eingangskamerasignalen funktioniert, die das Gerät noch nie zuvor gesehen hat, und ein verarbeitetes Signal kontinuierlich und mit minimaler Verzögerung als Reaktion auf die sich ständig ändernden Live-Videoeingänge liefert. In Anlehnung an die Tradition von Performance-Instrumenten der Audiosynthesewelt wie dem Theremin wurden Videosynthesizer mit der Erwartung entwickelt, dass sie in Live-Konzert-Theatersituationen gespielt oder in einem Studio aufgestellt werden, das bereit ist, ein Videoband von einem Wiedergabe-Videorecorder in realer Form zu verarbeiten Zeit während der Aufzeichnung der Ergebnisse auf einem zweiten Videorecorder. Veranstaltungsorte dieser Aufführungen waren „Electronic Visualization Events“ in Chicago, The Kitchen in NYC und Museumsinstallationen. Videokünstler / Performer Don Slepian entworfen, baute und führte ein fußgesteuertes visuelles Instrument im Centre Pompidou in Paris (1983) und im NY Open Centre durch, das frühe Mikrocomputer Apple II Plus mit dem Chromaton 14 Video Synthesizer kombinierte. und Kanäle für koloriertes Videofeedback.

Analoge und frühe digitale Echtzeitsynthesizer existierten vor der modernen 3D-Modellierung von Computern. Typische 3D-Renderer sind nicht in Echtzeit, da sie sich darauf konzentrieren, jedes Bild beispielsweise aus einem rekursiven Raytracing-Algorithmus zu berechnen, wie lange es auch dauert. Dies unterscheidet sie von Videosynthesizern, die zum Zeitpunkt der letzten Anzeige ein neues Ausgabebild liefern und diese Leistung kontinuierlich wiederholen müssen (normalerweise wird regelmäßig alle 1/60 oder 1/50 Sekunde ein neues Bild geliefert). Die Echtzeitbeschränkung führt zu einem Unterschied in der Entwurfsphilosophie zwischen diesen beiden Systemklassen.

Videosynthesizer überschneiden sich mit Video-Spezialeffektgeräten, die in Echtzeit-Fernsehsendungen und Postproduktionssituationen verwendet werden. Viele Innovationen bei Fernsehgeräten sowie Computergrafik-Displays sind aus Synthesizern hervorgegangen, die in der Community der Videokünstler entwickelt wurden, und diese Branchen unterstützen häufig „elektronische Kunstprojekte“ in diesem Bereich, um die Wertschätzung dieser Geschichte zu demonstrieren.

Zusammenfluss von Ideen der Elektronik und Kunst

Viele Prinzipien, die bei der Konstruktion früher Videosynthesizer verwendet wurden, spiegelten ein gesundes und dynamisches Zusammenspiel zwischen elektronischen Anforderungen und traditionellen Interpretationen künstlerischer Formen wider. Zum Beispiel haben Rutt & Etra und Sandin als wesentliche Grundgedanken von Robert Moog die standardisierten Signalbereiche übernommen, so dass der Ausgang eines Moduls mit dem Eingang eines anderen Moduls „spannungsgesteuert“ werden kann. Die Folge davon in einer Maschine wie der Rutt-Etra war, dass Position, Helligkeit und Farbe vollständig austauschbar waren und verwendet werden konnten, um sich während der Verarbeitung, die zum endgültigen Bild führte, gegenseitig zu modulieren. Videobänder von Louise und Bill Etra sowie Steina und Woody Vasulka dramatisierten diese neue Klasse von Effekten.

EMS Spectron

In Großbritannien entwickelte Richard Monkhouse, der für Electronic Music Studios (London) Limited (EMS) arbeitete, einen Hybrid-Videosynthesizer – Spectre -, der später in „Spectron“ umbenannt wurde und das EMS-Patchboard-System verwendete, um vollständig flexible Verbindungen zwischen Moduleingängen und -ausgängen zu ermöglichen. Die Videosignale waren digital, wurden jedoch durch analoge Spannungen gesteuert. Es gab ein digitales Patchboard für die Bildkomposition und ein analoges Patchboard für die Bewegungssteuerung.

Entwicklung zu Rahmenpuffern

Videosynthesizer wechselten von analog zu präzise digital. Die ersten digitalen Effekte, wie sie in Stephen Becks Video Weavings veranschaulicht werden, verwendeten digitale Oszillatoren, die optional mit horizontalen, vertikalen oder Frame-Resets verbunden sind, um Zeitrampen zu erzeugen. Diese Rampen konnten geschlossen werden, um das Videobild selbst zu erstellen, und waren für die zugrunde liegende geometrische Textur verantwortlich. Schier und Vasulka haben den Stand der Technik von Adresszählern zu programmierbaren (mikrocodierbaren) AMD Am2901-Bit-Slice-basierten Adressgeneratoren weiterentwickelt. Auf dem Datenpfad verwendeten sie 74S181-Arithmetik- und Logikeinheiten, die zuvor als Komponente für arithmetische Anweisungen in Minicomputern angesehen wurden, um Echtzeitvideosignale zu verarbeiten und neue Signale zu erstellen, die die Summe, Differenz UND UND, XOR usw. darstellen. von zwei Eingangssignalen. Diese beiden Elemente, der Adressgenerator,

Der Adressgenerator lieferte Lese- und Schreibadressen an einen Echtzeit-Videospeicher, der als Weiterentwicklung der flexibelsten Form des Zusammenführens der Adressbits zur Erzeugung des Videos angesehen werden kann. Während der Videobildpuffer jetzt in der Grafikkarte jedes Computers vorhanden ist, hat er eine Reihe von Funktionen der frühen Videosynths nicht übernommen. Der Adressgenerator zählt in einem festen rechteckigen Muster von der oberen linken Ecke des Bildschirms über jede Zeile bis zum unteren Rand. Dies verwarf eine ganze Technologie zum Modifizieren des Bildes durch Variationen in der Lese- und Schreibadressierungssequenz, die von den Hardwareadressengeneratoren bereitgestellt wurde, wenn das Bild durch den Speicher geleitet wurde. Heutzutage werden adressbasierte Verzerrungen häufiger durch Blitter-Operationen erreicht, die Daten in den Speicher verschieben.

Geschichte der Videosynthesizer, Designer und Künstler

1960er Jahre

1962, ANIMAC von Lee Harrison III: (Hybrid-Grafikanimationscomputer) – Vorgänger des Scanimate

1966, Dan Slaters Custom Vsynths: Dan Slater hat im Laufe der Jahre eine Reihe von Custom Homebrew Vsynths gebaut und mit Douglas Trumbull an verschiedenen Filmen gearbeitet.

1968 Eric Siegels PCS (Processing Chrominance Synthesizer)

1968, Computer Image Corporation Scanimate:

Video eines Nachrichtenberichts über Scanimate, einschließlich eines Interviews mit dem Erfinder Lee Harrison III

1969 Paik / Abe-Synthesizer

Erbaut im WGBH Boston Experimental TV Center, entworfen von Nam June Paik, entworfen von der Künstlerin / Ingenieurin Shuya Abe.

Jim Wiseman hat mehrere in CalArts und im Experimental TV Center der Binghamton University, WNET, NYC, gebaute, die noch in Betrieb sind

Klicken Sie auf die Überschrift für eine spezielle Seite mit umfangreichen Real-Videoclips

1969, Bill Hearns VIDIUM: (Analoger XYZ-Treiber / Sequenzer)

1969, CVI Quantizer & CVI Data Camera von Glen Southworth

1970–1974

1970 Eric Siegels EVS Electronic Video Synthesizer & Dual Colorizer (analog)

1970, Groove & VAmpire

(Generierte Echtzeit-Ausgangsoperationen an spannungsgesteuerten Geräten)

(Video- und Musikprogramm für interaktive Echtzeiterkundung / -experimente).

1970, Lear Sieglers vsynth: Einzigartiger Hi-Rez-Videoprozessor, der im Film „Andromeda Strain“ und von Douglas Trumbull & Dan Slater verwendet wird

Stephen Becks Direct Video Synth & Beck Video Weaver

Stephen Beck schuf einige Synthesizer der frühen 70er Jahre, die keine Videoeingänge hatten. Sie machten Videos nur aus Schwingungen.

Er modifizierte auch einige Paik / Abe-Einheiten.

Sherman WALTER WRIGHT: Als einer der ersten Videoanimatoren arbeitete er in den frühen 70er Jahren bei Computer Image Corp. und später bei Dolphin Productions, wo er ein Scanimate betrieb. Während seiner Zeit bei Dolphin arbeiteten Ed Emshwiller und er zusammen an Thermogenisis und Scapemates und er machte auch mehrere Bänder selbst. In den Jahren 1973 bis 1976 war er als Artist-in-Residence am Experimental Television Center in New York Pionier der Video-Performance in öffentlichen Zugangszentren, Colleges und Galerien mit dem Paik / Abe-Videosynthesizer. Er arbeitete auch mit den Sequenziermodulen David Jones Colorizer & Rich Brewsters. Diese verschiedenen Module basierten auf Davids Design für spannungsgesteuerte Videoverstärker und wurden zur Grundlage für das ETC-Studio. Er war dort, als Don McArthur die SAID baute. Woody Vasulka und Jeff Schier waren in Buffalo in der Nähe und bauten computergestützte Module, darunter einen Frame Buffer mit eingebauten ALUs, Mixer, Keyer und Colorizer. Wright arbeitete auch mit Gary Hill bei Woodstock Community Video zusammen, wo wöchentlich eine Kabelshow mit Live-Video- / Audiosynthese stattfand. Wright hat sein eigenes Performance-Videosystem, den Video Shredder, entwickelt und fasziniert damit das Publikum, wo und wann immer er kann. Er wird ziemlich gut darin. Seine Mission ist es, eine neue Musik aus Ton und Bild zu schaffen. Er hat an der gesamten Ostküste der USA und Kanadas in Kunstgalerien und Museen, Schulen und Hochschulen, Medienzentren, Konferenzen und Festivals gespielt. Dort gab es eine wöchentliche Kabelshow mit Live-Video- / Audiosynthese. Wright hat sein eigenes Performance-Videosystem, den Video Shredder, entwickelt und fasziniert damit das Publikum, wo und wann immer er kann. Er wird ziemlich gut darin. Seine Mission ist es, eine neue Musik aus Ton und Bild zu schaffen. Er hat an der gesamten Ostküste der USA und Kanadas in Kunstgalerien und Museen, Schulen und Hochschulen, Medienzentren, Konferenzen und Festivals gespielt. Dort gab es eine wöchentliche Kabelshow mit Live-Video- / Audiosynthese. Wright hat sein eigenes Performance-Videosystem, den Video Shredder, entwickelt und fasziniert damit das Publikum, wo und wann immer er kann. Er wird ziemlich gut darin. Seine Mission ist es, eine neue Musik aus Ton und Bild zu schaffen. Er hat an der gesamten Ostküste der USA und Kanadas in Kunstgalerien und Museen, Schulen und Hochschulen, Medienzentren, Konferenzen und Festivals gespielt.

1971, Sandin Image Processor: Sehr früher Videosynth …. DIY modular, gebaut von Dan Sandin aus Chicago.

1972, Rutt / Etra-Videosynthesizer: Dieser von Steve Rutt & Bill Etra gemeinsam erfundene analoge Computer für die Manipulation von Videoraster.

1973 veröffentlicht Phil Morton „Notes on the Aesthetics of Copying a Image Processor“. Er „bezeichnete sich stolz als den“ ersten Kopierer „von Sandins Bildprozessor. Der Sandin-Bildprozessor bot Künstlern beispiellose Möglichkeiten, Echtzeit-Video und -Audio zu erstellen, zu verarbeiten und zu beeinflussen, und ermöglichte Performances, die buchstäblich die Bühne für aktuelles Echtzeit-Audio-Video Neu bereiteten Medienkunst. “

1974, VSYNTH’s von David Jones: Viele Kreationen, die bekannteste ist der Jones Colorizer, ein spannungssteuerbarer Vierkanal-Colorizer mit Graustufen-Keyer.

1974, EMS Spectre: Innovativer Videosynthesizer mit analogen und digitalen Techniken, entwickelt von Richard Monkhouse bei EMS. Später umbenannt in „Spectron“.

1975–1979

1975, Dave Jones Video Digitizer: Ein früher digitaler Videoprozessor für Videokunst. Es wurde in Echtzeit digitalisiert (keine Beispieluhr) und eine 4-Bit-ALU verwendet, um Farbeffekte zu erstellen

1975, Don McArthurs SAID: Don McArthur entwickelte mit Dave Jones den SAID (Spatial and Intensity Digitizer), ein Ergebnis der Forschung an einem Schwarz-Weiß-Zeitbasis-Korrektor

1976, Denise Gallants vsynth: Entwickelte Ende der 70er Jahre einen sehr fortschrittlichen analogen Videosynthesizer.

1976, Chromaton 14

Ein ziemlich kleiner analoger Videosynthesizer mit Farbquantisierern und kann komplexe Farbbilder ohne externe Eingaben erzeugen.

Gebaut von BJA Systems

1977, Jones Frame Buffer: Digitale Frame-Speicherung von Videosignalen mit niedriger Auflösung (Versionen mit höherer Auflösung und Versionen mit mehreren Frames wurden 1979 und in den frühen 1980er Jahren hergestellt)

1979, Chromachron: Einer der ersten DIGITAL VSynths. – Entworfen von Ed Tannenbaum.

1979, Chromascope Video Synthesizer, PAL- und NTSC-Versionen. Erstellt von Robin Palmer. Hergestellt von Chromatronics, Essex, UK. Vertrieb durch CEL Electronics. Modell P135 (2.000 Einheiten gebaut) und Modell C.101 (100 Einheiten gebaut).

1980er Jahre

1984, Fairlight CVI Computer Video Instrument: Der Fairlight CVI wurde in den frühen 80er Jahren hergestellt und ist ein hybrider analoger digitaler Videoprozessor.

2000er Jahre

2008 gründeten Lars Larsen und Ed Leckie LZX Industries und begannen mit der Entwicklung neuer analoger Videosynthesemodule (Visionary, Cadet und Expedition Series).

2011, Critter & Guitari Video Scope: voreingestellter Videosynthesizer.

2013, Critter & Guitari Rhythm Scope: voreingestellter Videosynthesizer.

2014, Critter & Guitari Black & White Video Scope: voreingestellter Videosynthesizer.

2014, Ming Mekka: Modularer, auf Pixelkunst ausgerichteter analoger Videosynth

2016, Paracosm Lumen: Semimodularer Software-Videosynth für MacOS.

2016, Vsynth: Ein modulares Software-Video-Synthesizer-Paket für Max / Jitter.

2016, Ming Micro: Pixelkunst-orientierter digitaler Videosynth

2017, Critter & Guitari ETC: Videosynthesizer, der 720p-Ausgabe unterstützt.