Für jedes mobile Gerät ist es wichtig, in seiner Umgebung navigieren zu können. Das Vermeiden gefährlicher Situationen wie Kollisionen und unsichere Bedingungen (Temperatur, Strahlung, Witterung usw.) steht an erster Stelle. Wenn der Roboter jedoch einen bestimmten Zweck in Bezug auf bestimmte Orte in der Roboterumgebung verfolgt, muss er diese Orte finden. Dieser Artikel gibt einen Überblick über die Fähigkeiten der Navigation und versucht, die Grundblöcke eines Roboternavigationssystems, die Arten von Navigationssystemen und die zugehörigen Gebäudekomponenten zu identifizieren.

Roboternavigation bedeutet, dass der Roboter seine eigene Position in seinem Referenzrahmen bestimmen und dann einen Weg in Richtung einer Zielposition planen kann. Um in seiner Umgebung navigieren zu können, benötigt der Roboter oder ein anderes Mobilitätsgerät eine Repräsentation, dh eine Umgebungskarte und die Fähigkeit, diese Repräsentation zu interpretieren.

Navigation kann als Kombination der drei Grundkompetenzen definiert werden:

Selbstlokalisierung

Pfadplanung

Kartenaufbau und Karteninterpretation

„Karte“ bezeichnet in diesem Zusammenhang jede Eins-zu-Eins-Abbildung der Welt auf eine interne Darstellung.

Roboterlokalisierung bezeichnet die Fähigkeit des Roboters, seine eigene Position und Orientierung innerhalb des Bezugsrahmens festzulegen. Die Pfadplanung ist effektiv eine Erweiterung der Lokalisierung, da sie die Bestimmung der aktuellen Position des Roboters und einer Position eines Zielorts sowohl innerhalb desselben Bezugsrahmens als auch derselben Koordinaten erfordert. Das Erstellen von Karten kann in Form einer Metrikkarte oder einer beliebigen Beschreibung der Positionen im Referenzrahmen des Roboters erfolgen.

Vision-basierte Navigation

Vision-basierte Navigation oder optische Navigation verwendet Computer-Vision-Algorithmen und optische Sensoren, einschließlich lasergestützter Entfernungsmesser und photometrischer Kameras mit CCD-Arrays, um die für die Lokalisierung in der Umgebung erforderlichen visuellen Merkmale zu extrahieren. Es gibt jedoch eine Reihe von Techniken zur Navigation und Lokalisierung unter Verwendung von Sichtinformationen. Die Hauptkomponenten jeder Technik sind:

Darstellungen der Umgebung.

Sensormodelle.

Lokalisierungsalgorithmen.

Um einen Überblick über die visionsbasierte Navigation und ihre Techniken zu geben, klassifizieren wir diese Techniken unter Innennavigation und Außennavigation.

Indoor-Navigation

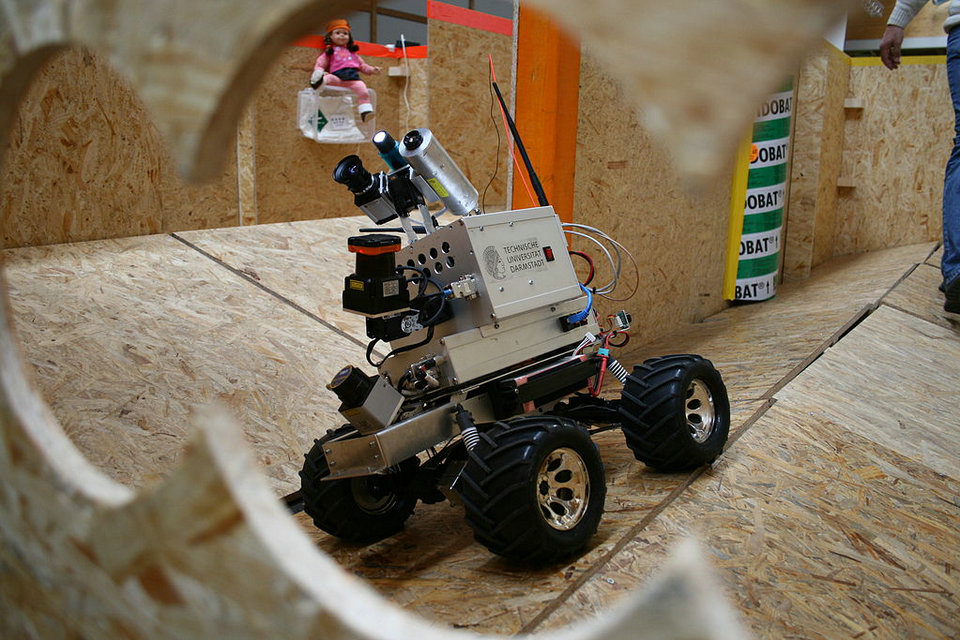

Der einfachste Weg, einen Roboter zum Zielort zu bringen, besteht darin, ihn einfach an diesen Ort zu führen. Diese Anleitung kann auf verschiedene Arten durchgeführt werden: Vergraben einer induktiven Schleife oder von Magneten im Boden, Malen von Linien auf dem Boden oder Platzieren von Baken, Markierungen, Barcodes usw. in der Umgebung. Solche Automated Guided Vehicles (AGVs) werden in industriellen Szenarien für Transportaufgaben eingesetzt. Indoor Navigation von Robotern ist mit IMU-basierten Indoor-Positionierungsgeräten möglich.

Es gibt eine sehr große Auswahl an Indoor-Navigationssystemen. Die Basisreferenz für Indoor- und Outdoor-Navigationssysteme ist „Vision für mobile Roboternavigation: Eine Umfrage“ von Guilherme N. DeSouza und Avinash C. Kak.

AVM Navigator

AVM Navigator ist ein zusätzliches Modul des RoboRealm (Plugin), das Objekterkennung und autonome Roboternavigation mithilfe einer einzigen Videokamera des Roboters als Hauptsensor für die Navigation ermöglicht.

Dies ist aufgrund der Verwendung eines „Associative Video Memory“ (AVM) -Algorithmus möglich, der auf einer mehrstufigen Zerlegung von Erkennungsmatrizen basiert. Es ermöglicht die Bilderkennung mit einer niedrigen Falschakzeptanz (etwa 0,01%). In diesem Fall ist die visuelle Navigation nur die Folge von Bildern (Landmarken) mit zugehörigen Koordinaten, die während des Routentrainings im AVM-Baum gespeichert wurden. Die Navigationskarte wird als Datensatz dargestellt (z. B. X-, Y-Koordinaten und Azimut), der mit Bildern im AVM-Baum verknüpft ist. Wenn ein Roboter Bilder von der Kamera erkennt (Marken), die erkannt werden können, bestätigt er seinen aktuellen Standort.

Der Navigator erstellt einen Weg von der aktuellen Position zur Zielposition als Kette von Wegpunkten. Wenn die aktuelle Ausrichtung des Roboters nicht auf den nächsten Wegpunkt zeigt, dreht der Navigator den Roboterkörper. Wenn der Roboter einen Wegpunkt erreicht, wechselt der Navigator zum nächsten Wegpunkt in der Kette und so weiter, bis die Zielposition erreicht ist.

Outdoor-Navigation

Einige neuere Outdoor-Navigationsalgorithmen basieren auf dem neuronalen Faltungsnetzwerk und dem maschinellen Lernen und sind in der Lage, eine genaue Turn-by-Turn-Inferenz durchzuführen.

Autonome Flugsteuerungen

Typische autonome Open Source-Flugcontroller können im vollautomatischen Modus fliegen und die folgenden Vorgänge ausführen:

Starten Sie vom Boden und fliegen Sie in eine definierte Höhe

Fliegen Sie zu einem oder mehreren Wegpunkten

Umrunden Sie einen bestimmten Punkt

Rückkehr zur Startposition

Steigen Sie mit einer bestimmten Geschwindigkeit ab und landen Sie das Flugzeug

Die an Bord befindliche Flugsteuerung verwendet GPS für die Navigation und den stabilisierten Flug und verwendet häufig zusätzliche satellitengestützte Augmentationssysteme (SBAS) und einen Höhensensor (barometrischer Druck).