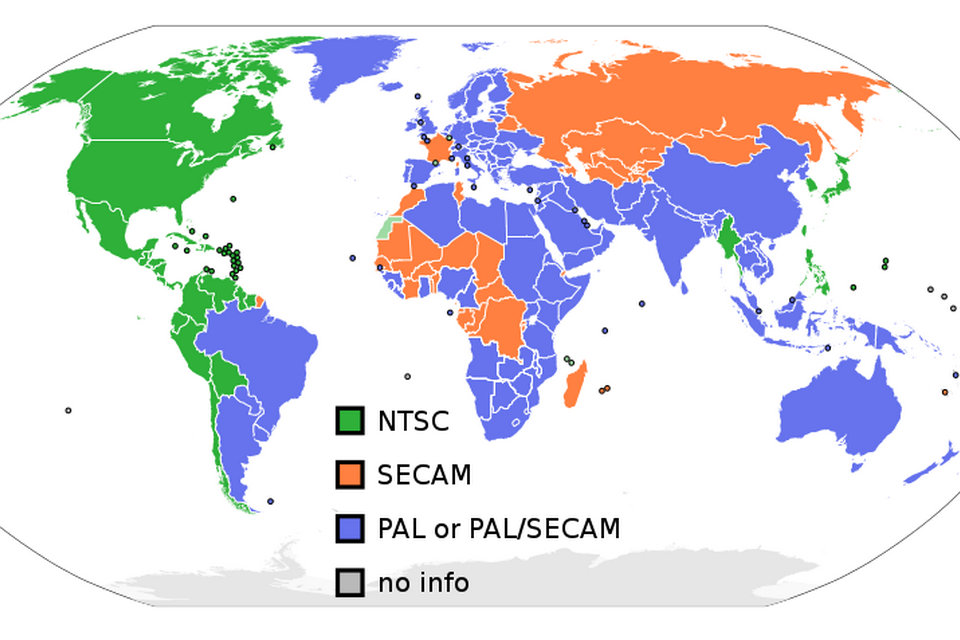

NTSC, benannt nach dem National Television System Committee, ist das analoge Fernsehsystem, das in Nordamerika verwendet wird und bis zur digitalen Umwandlung in den meisten Amerikas (außer Brasilien, Argentinien, Paraguay, Uruguay und Französisch-Guayana) verwendet wurde; Myanmar; Südkorea; Taiwan; Philippinen, Japan; und einige pazifische Inselnationen und -territorien.

Der erste NTSC-Standard wurde 1941 entwickelt und hatte keine Farbbestimmung. Im Jahr 1953 wurde ein zweiter NTSC-Standard eingeführt, der eine Farbfernsehübertragung ermöglichte, die mit dem vorhandenen Bestand an Schwarz-Weiß-Empfängern kompatibel war. NTSC war das erste weit verbreitete Broadcast-Farbsystem und blieb bis in die 2000er Jahre dominant, als es durch verschiedene digitale Standards wie ATSC und andere ersetzt wurde.

Die meisten Länder, die den NTSC-Standard verwenden, sowie jene, die andere analoge Fernsehnormen verwenden, haben auf neuere digitale Fernsehnormen umgestellt oder sind gerade dabei, auf diese umzustellen, da weltweit mindestens vier verschiedene Standards verwendet werden. Nordamerika, Teile von Zentralamerika und Südkorea übernehmen die ATSC-Standards oder haben diese übernommen, während andere Länder (wie Japan) anstelle von ATSC andere Standards übernehmen oder übernommen haben. Nach fast 70 Jahren wurde der Großteil der drahtlosen NTSC-Übertragungen in den USA am 1. Januar 2010 und bis zum 31. August 2011 in Kanada und den meisten anderen NTSC-Märkten eingestellt. Die Mehrzahl der NTSC-Übertragungen endete am 24. Juli 2011 in Japan, die japanischen Präfekturen Iwate, Miyagi und Fukushima beendeten das nächste Jahr. Nach einem Pilotprogramm im Jahr 2013 haben die meisten Analogstationen mit voller Leistung in Mexiko an zehn Terminen im Jahr 2015 den Flug verlassen. Bis Ende 2016 können etwa 500 Low-Power- und Repeater-Stationen analog bleiben. Die digitale Übertragung ermöglicht eine höhere Auflösung Fernsehen, aber digitales Standarddefinitionsfernsehen verwendet weiterhin die Bildfrequenz und die Anzahl von Zeilen der Auflösung, die durch den analogen NTSC-Standard festgelegt werden.

Geschichte

Das National Television System Committee wurde 1940 von der Federal Communications Commission (FCC) der Vereinigten Staaten gegründet, um die Konflikte zwischen Unternehmen über die Einführung eines landesweiten analogen Fernsehsystems in den USA zu lösen. Im März 1941 gab das Komitee einen technischen Standard für Schwarz-Weiß-Fernsehen heraus, der auf einer Empfehlung des Radio Manufacturers Association (RMA) von 1936 aufbaute. Technische Weiterentwicklungen der Restseitenbandtechnik ermöglichten die Möglichkeit, die Bildauflösung zu erhöhen. Der NTSC wählte 525 Scanlinien als Kompromiss zwischen dem 441-Scanzeilenstandard von RCA und dem Wunsch von Philco und DuMont, die Anzahl der Scanzeilen auf zwischen 605 und 800 zu erhöhen. Der Standard empfahl eine Bildrate von 30 Frames (Bildern) pro Sekunde von zwei verschachtelten Halbbildern pro Vollbild bei 262,5 Zeilen pro Halbbild und 60 Halbbildern pro Sekunde. Andere Standards in der endgültigen Empfehlung waren ein Seitenverhältnis von 4: 3 und eine Frequenzmodulation (FM) für das Tonsignal (das zu dieser Zeit ziemlich neu war).

Im Januar 1950 wurde das Komitee neu gegründet, um das Farbfernsehen zu standardisieren. Die FCC hatte kurz im Oktober 1950 einen Farbfernsehstandard genehmigt, der von CBS entwickelt wurde. Das CBS-System ist mit bestehenden Schwarz-Weiß-Empfängern nicht kompatibel. Es verwendet ein rotierendes Farbrad, reduziert die Anzahl der Scanzeilen von 525 auf 405 und erhöht die Bildrate von 60 auf 144, hat aber eine effektive Bildrate von nur 24 Bildern pro Sekunde. Die Klage des Rivalen RCA ließ das System bis Juni 1951 kommerziell ausstrahlen. Regelmäßige Sendungen dauerten nur einige Monate, bis die Herstellung aller Farbfernsehgeräte im Oktober durch das Büro des Verteidigungsministeriums verboten wurde, angeblich wegen des Koreakrieges . CBS hob sein System im März 1953 auf, und die FCC ersetzte es am 17. Dezember 1953 durch den NTSC-Farbstandard, der von mehreren Firmen, darunter RCA und Philco, kooperativ entwickelt wurde.

Im Dezember 1953 billigte die FCC einstimmig den heute als NTSC-Farbfernsehnorm bezeichneten Standard (später als RS-170a definiert). Der kompatible Farbstandard behält die volle Rückwärtskompatibilität mit bestehenden Schwarzweiß-Fernsehgeräten bei. Farbinformation wurde zu dem Schwarz-Weiß-Bild hinzugefügt, indem ein Farbhilfsträger von genau 315/88 MHz (gewöhnlich beschrieben als 3,579545 MHz oder 3,58 MHz) eingeführt wurde. Die genaue Frequenz wurde so gewählt, dass horizontale Zeilenratenmodulationskomponenten des Chrominanzsignals genau zwischen die horizontalen Zeilenratenmodulationskomponenten des Luminanzsignals fallen, wodurch ermöglicht wird, dass das Chrominanzsignal aus dem Luminanzsignal herausgefiltert wird mit geringer Verschlechterung von das Luminanzsignal. Aufgrund von Beschränkungen der Frequenzteilerschaltungen zu der Zeit, als der Farbstandard bekannt gemacht wurde, wurde die Farbhilfsträgerfrequenz als zusammengesetzte Frequenz konstruiert, die aus kleinen ganzen Zahlen zusammengesetzt war, in diesem Fall 5 × 7 × 9 / (8 × 11) MHz. Die horizontale Zeilenrate wurde von 15.750 Zeilen pro Sekunde auf etwa 15.734 Zeilen pro Sekunde (3.579545 × 2/455 MHz = 9/572 MHz) reduziert, und die Bildrate wurde auf 30 / 1.001 ≈ 29.970 Bilder pro Sekunde (die horizontale Linie) reduziert Rate geteilt durch 525 Zeilen / Frame) aus 30 Frames pro Sekunde. Diese Änderungen betragen 0,1 Prozent und wurden von bestehenden Fernsehempfängern problemlos toleriert.

Die erste öffentlich angekündigte Netzwerk-Fernsehübertragung eines Programms, das das NTSC- „kompatible Farbsystem“ verwendete, war eine Episode der Kukla, Fran und Ollie von NBC am 30. August 1953, obwohl sie nur in der Hauptniederlassung des Netzes in Farbe gesehen werden konnte. Die erste landesweite Betrachtung der NTSC-Farben fand am folgenden 1. Januar mit der Sendung „Tournament of Roses Parade“ von Küste zu Küste statt, die bei speziellen Präsentationen im ganzen Land auf Prototypen-Farbempfängern zu sehen ist. Die erste Farb-NTSC-Fernsehkamera war die RCA TK-40, die 1953 für experimentelle Übertragungen verwendet wurde; eine verbesserte Version, die im März 1954 eingeführte TK-40A, war die erste kommerziell erhältliche Farbfernsehkamera. Später in diesem Jahr wurde die verbesserte TK-41 zur Standardkamera, die in den 60er Jahren verwendet wurde.

Der NTSC-Standard wurde von anderen Ländern übernommen, einschließlich des Großteils von Amerika und Japan.

Mit dem Aufkommen des digitalen Fernsehens werden analoge Sendungen ausgemustert. Die meisten US-amerikanischen NTSC-Sender wurden 2009 von der FCC aufgefordert, ihre analogen Sender abzuschalten. Kraftwerke, A-Stationen und Übersetzer mussten bis 2015 abgeschaltet werden.

Technische Details

Zeilen und Bildwiederholfrequenz

Die NTSC-Farbcodierung wird mit dem System M-Fernsehsignal verwendet, das aus 30/1,001 (etwa 29,97) Zeilensprung-Videobildern pro Sekunde besteht. Jeder Rahmen besteht aus zwei Feldern, die jeweils aus 262,5 Scanzeilen bestehen, also insgesamt 525 Scanzeilen. 483 Scanlinien bilden das sichtbare Raster. Der Rest (das vertikale Austastintervall) ermöglicht eine vertikale Synchronisation und einen Rücklauf. Dieses Austastintervall wurde ursprünglich entworfen, um die CRT des Empfängers einfach auszublenden, um die einfachen Analogschaltungen und den langsamen Vertikalrücklauf früher Fernsehempfänger zu ermöglichen. Einige dieser Zeilen enthalten jedoch möglicherweise andere Daten wie Untertitel und vertikaler Intervall-Timecode (VITC). Im vollständigen Raster (unter Vernachlässigung der Halbzeilen durch Interlacing) werden die geradzahligen Scanzeilen (jede zweite Zeile, die im Video-Signal gerade gezählt würde, z. B. {2, 4, 6, …, 524}) gezeichnet im ersten Feld, und die ungeradzahligen (jede andere Zeile, die im Videosignal ungerade wäre, z. B. {1, 3, 5, …, 525}), werden im zweiten Feld gezeichnet, um a zu erhalten flimmerfreies Bild bei der Bildwiederholfrequenz von 60/1,001 Hz (etwa 59,94 Hz). Zum Vergleich verwenden 576i-Systeme wie PAL-B / G und SECAM 625 Zeilen (576 sichtbar) und haben somit eine höhere vertikale Auflösung, aber eine geringere zeitliche Auflösung von 25 Bildern oder 50 Halbbildern pro Sekunde.

Die NTSC-Feld-Refresh-Frequenz in dem Schwarz-Weiß-System stimmte ursprünglich genau mit der Nennfrequenz von 60 Hz der in den Vereinigten Staaten verwendeten Wechselstromleistung überein. Durch die Anpassung der Bildwiederholfrequenz an die Stromquelle wurde eine Intermodulation (auch als Schwebung bezeichnet) vermieden, die Rollbalken auf dem Bildschirm erzeugt. Die Synchronisierung der Bildwiederholrate mit der Leistung half übrigens, dass die Bildröhren-Kameras frühe Live-Fernsehübertragungen aufnahmen, da es sehr einfach war, eine Filmkamera zu synchronisieren, um einen Bildrahmen auf jedem Filmrahmen zu erfassen, indem die Wechselstromfrequenz verwendet wurde Synchron-AC-Motor-Kamera. Wenn dem System Farbe hinzugefügt wurde, wurde die Auffrischungsfrequenz geringfügig um 0,1% auf etwa 59,94 Hz nach unten verschoben, um stationäre Punktmuster in der Differenzfrequenz zwischen Ton- und Farbträgern zu eliminieren, wie unten unter „Farbcodierung“ erläutert. Zu dem Zeitpunkt, an dem sich die Bildrate änderte, um Farbe anzupassen, war es fast so einfach, den Kameraverschluss aus dem Videosignal selbst auszulösen.

Die tatsächliche Zahl von 525 Zeilen wurde als eine Folge der Beschränkungen der vakuumröhrenbasierten Technologien der Zeit gewählt. In frühen Fernsehsystemen wurde ein spannungsgesteuerter Hauptoszillator mit der doppelten horizontalen Zeilenfrequenz betrieben, und diese Frequenz wurde durch die Anzahl der verwendeten Zeilen (in diesem Fall 525) heruntergeteilt, um die Feldfrequenz (in diesem Fall 60 Hz) zu ergeben. . Diese Frequenz wurde dann mit der 60 Hz-Netzfrequenz verglichen und jede Abweichung durch Einstellen der Frequenz des Hauptoszillators korrigiert. Für die Zeilensprungabtastung wurde eine ungerade Anzahl von Zeilen pro Vollbild benötigt, um die Vertikalrücklaufdistanz für die ungeraden und geraden Halbbilder identisch zu machen, was bedeutete, dass die Hauptoszillatorfrequenz durch eine ungerade Zahl heruntergeteilt werden musste. Zu dieser Zeit war die einzige praktische Methode der Frequenzteilung die Verwendung einer Kette von Vakuumröhren-Multivibratoren, wobei das Gesamtteilungsverhältnis das mathematische Produkt der Teilungsverhältnisse der Kette ist. Da alle Faktoren einer ungeraden Zahl auch ungerade Zahlen sein müssen, folgt, dass alle Teiler in der Kette auch durch ungerade Zahlen geteilt werden mussten, und diese mussten aufgrund der Probleme der thermischen Drift mit Vakuumröhrenvorrichtungen relativ klein sein . Die nächste praktische Sequenz zu 500, die diese Kriterien erfüllt, war 3 × 5 × 5 × 7 = 525. (Aus dem gleichen Grund, 625-Zeilen-PAL-B / G und SECAM verwendet 5 × 5 × 5 × 5, das alte britische 405-Zeilen-System verwendet 3 × 3 × 3 × 3 × 5, das Französisch 819-Zeilensystem verwendet 3 × 3 × 7 × 13 usw.)

Farbmetrik

Die ursprüngliche Farb-NTSC-Spezifikation von 1953, die immer noch Teil des United States Code of Federal Regulations ist, definierte die kolorimetrischen Werte des Systems wie folgt:

| Original NTSC Farbmessung (1953) | CIE 1931 x | CIE 1931 y |

|---|---|---|

| Primär rot | 0.67 | 0,33 |

| Primär grün | 0.21 | 0,71 |

| Primär blau | 0.14 | 0,08 |

| Weißpunkt (CIE-Normlichtart C) 6774 K | 0.310 | 0.316 |

Frühe Farbfernsehempfänger, wie der RCA CT-100, waren dieser Spezifikation (die auf vorherrschenden Filmstandards basierte) treu und hatten einen größeren Tonumfang als die meisten der heutigen Monitore. Ihre Leuchtstoffe mit niedriger Effizienz (insbesondere im Roten) waren schwach und langlebig und hinterließen Spuren nach bewegten Objekten. Beginnend in den späten 1950ern würden Bildröhrenleuchtstoffe die Sättigung für eine erhöhte Helligkeit opfern; Diese Abweichung vom Standard sowohl beim Empfänger als auch beim Sender war die Ursache für erhebliche Farbabweichungen.

SMPTE C

Um eine einheitlichere Farbwiedergabe zu gewährleisten, begannen die Empfänger, Farbkorrekturschaltungen einzubauen, die das empfangene Signal – codiert für die oben aufgeführten kolorimetrischen Werte – in Signale umwandeln, die für die tatsächlich in dem Monitor verwendeten Leuchtstoffe codiert sind. Da eine solche Farbkorrektur bei den übertragenen nichtlinearen gammakorrigierten Signalen nicht genau durchgeführt werden kann, kann die Einstellung nur approximiert werden, indem sowohl Farbton- als auch Luminanzfehler für stark gesättigte Farben eingeführt werden.

1968/69 definierte die Conrac Corp. in Zusammenarbeit mit RCA eine Reihe von kontrollierten Leuchtstoffen zur Verwendung in Broadcast-Farbbildvideomonitoren. Diese Spezifikation überlebt heute als SMPTE „C“ -Phosphorspezifikation:

| SMPTE „C“ -Kolorimetrie | CIE 1931 x | CIE 1931 y |

|---|---|---|

| Primär rot | 0.630 | 0,340 |

| Primär grün | 0.310 | 0,595 |

| Primär blau | 0,155 | 0,070 |

| Weißpunkt (CIE-Leuchtmittel D65) | 0.3127 | 0.3290 |

Wie bei Heimempfängern wurde ferner empfohlen, dass Studiomonitore ähnliche Farbkorrekturschaltungen verwenden, so dass die Sender gemäß den FCC-Standards Bilder übertragen, die für die ursprünglichen kolorimetrischen Werte von 1953 codiert sind.

Im Jahr 1987 verabschiedete das SMPTE-Komitee für Fernsehtechnik, Arbeitsgruppe für Studio Monitor Colorimetry, die SMPTE C (Conrac) -Leuchtstoffe für den allgemeinen Gebrauch in Recommended Practice 145, was viele Hersteller dazu veranlasste, ihre Kameradesigns zu modifizieren direkt für SMPTE „C“ -Kolorimetrie ohne Farbkorrektur zu kodieren, wie in SMPTE-Standard 170M, „Analoges Videosignalgemisch – NTSC für Studioanwendungen“ (1994) genehmigt. Als Konsequenz besagt der ATSC-Digitalfernsehnstandard, dass für 480i-Signale eine SMPTE „C“ -Kolorimetrie angenommen werden sollte, sofern nicht kolorimetrische Daten in dem Transportstrom enthalten sind.

Japanisches NTSC änderte niemals Primär- und Weißpunkt zu SMPTE „C“ und verwendete weiterhin die 1953 NTSC-Primärfarben und Weißpunkte. Sowohl das PAL- als auch das SECAM-System verwendeten die ursprüngliche 1953-NTSC-Kolorimetrie bis 1970; Im Gegensatz zu NTSC lehnte die European Broadcasting Union (EBU) jedoch in diesem Jahr die Farbkorrektur in Empfängern und Studiomonitoren ab und forderte stattdessen explizit, dass alle Geräte Signale für die „EBU“ -farbmetrischen Werte direkt codierten, was die Farbtreue dieser Systeme weiter verbesserte.

Farbcodierung

Für die Rückwärtskompatibilität mit Schwarz-Weiß-Fernsehen verwendet NTSC ein Luminanz-Chrominanz-Kodierungssystem, das 1938 von Georges Valensi erfunden wurde. Die drei Farbbildsignale sind unterteilt in Luminanz (mathematisch abgeleitet von den drei getrennten Farbsignalen (Rot, Grün und Blau)), die an die Stelle des ursprünglichen monochromen Signals tritt, und Chrominanz, die nur die Farbinformation trägt. Dieser Prozess wird durch einen eigenen Colorplexer auf jede Farbquelle angewendet, wodurch eine kompatible Farbquelle verwaltet werden kann, als ob es sich um eine normale monochrome Quelle handeln würde. Dies ermöglicht Schwarz-Weiß-Empfängern, NTSC-Farbsignale anzuzeigen, indem einfach das Chrominanzsignal ignoriert wird. Einige Schwarz-Weiß-Fernseher, die in den USA nach der Einführung der Farbübertragung im Jahr 1953 verkauft wurden, wurden entwickelt, um Chroma zu filtern, aber die frühen B & W-Sets taten dies nicht und Chrominanz konnte als „Punktmuster“ in stark gefärbten Bereichen angesehen werden des Bildes.

In NTSC wird Chrominanz unter Verwendung von zwei Farbsignalen, die als I (In-Phase) und Q (in Quadratur) bekannt sind, in einem Prozess, der QAM genannt wird, codiert. Die zwei Signale jeder Amplitude modulieren 3,58 MHz Träger, die um 90 Grad zueinander phasenverschoben sind, und das Ergebnis wird addiert, wobei jedoch die Träger selbst unterdrückt werden. Das Ergebnis kann als eine einzelne Sinuswelle mit variierender Phase relativ zu einem Referenzträger und mit variierender Amplitude betrachtet werden. Die variierende Phase stellt den momentanen Farbton dar, der von einer TV-Kamera aufgenommen wird, und die Amplitude repräsentiert die momentane Farbsättigung. Dieser 3,58 MHz-Hilfsträger wird dann zu der Leuchtdichte addiert, um das „zusammengesetzte Farbsignal“ zu bilden, das den Videosignalträger ebenso wie bei der monochromen Übertragung moduliert.

Damit ein Farbfernsehgerät Farbtoninformationen von dem Farbhilfsträger wiedergewinnt, muss es eine Nullphasenreferenz haben, um den zuvor unterdrückten Träger zu ersetzen. Das NTSC-Signal enthält eine kurze Abtastung dieses Bezugssignals, bekannt als der Farbburst, der sich auf der „hinteren Veranda“ jedes horizontalen Synchronisationsimpulses befindet. Der Farbburst besteht aus mindestens acht Zyklen des unmodulierten Farbhilfsträgers (feste Phase und Amplitude). Der Fernsehempfänger hat einen „lokalen Oszillator“, der mit diesen Farbsignalen synchronisiert ist. Die Kombination dieses von dem Farbsynchronsignal abgeleiteten Referenzphasensignals mit der Amplitude und Phase des Chrominanzsignals ermöglicht die Wiederherstellung der „I“ – und „Q“ -Signale, die in Kombination mit der Luminanzinformation die Rekonstruktion eines Farbbildes auf dem Bildschirm ermöglichen. Von Farbfernsehgeräten wird gesagt, dass sie aufgrund der vollständigen Trennung des Helligkeitsteils des Bildes von dem Farbteil tatsächlich ein Farbfernsehgerät sind. Bei CRT-Fernsehern wird das NTSC-Signal in drei Farbsignale umgewandelt, die als Rot, Grün und Blau bezeichnet werden, wobei jedes diese Farbelektronenkanone steuert. Fernsehgeräte mit digitalen Schaltungen verwenden Abtasttechniken, um die Signale zu verarbeiten, aber das Endergebnis ist das gleiche. Für analoge und digitale Sätze, die ein analoges NTSC-Signal verarbeiten, werden die ursprünglichen drei Farbsignale (Rot, Grün und Blau) unter Verwendung von drei diskreten Signalen (Luminanz, I und Q) übertragen und dann als drei getrennte Farben wiedergewonnen und als ein Farbbild kombiniert .

Wenn ein Sender ein NTSC-Signal sendet, moduliert er einen Radiofrequenzträger mit dem gerade beschriebenen NTSC-Signal amplitudenmoduliert, während er einen um 4,5 MHz höheren Träger mit dem Audiosignal frequenzmoduliert. Wenn eine nichtlineare Verzerrung mit dem Rundfunksignal auftritt, kann der 3,579545 MHz-Farbträger mit dem Tonträger schlagen, um ein Punktmuster auf dem Bildschirm zu erzeugen. Um das resultierende Muster weniger auffällig zu machen, passten die Designer die ursprüngliche Scanline-Rate von 15.750 Hz um einen Faktor von 1.001 (0.1%) an die Audioträgerfrequenz geteilt durch den Faktor 286 an, was zu einer Halbbildrate von ungefähr 59.94 Hz führte. Diese Einstellung stellt sicher, dass die Summen und Differenzen des Tonträgers und des Farbhilfsträgers und deren Vielfache (dh die Intermodulationsprodukte der beiden Träger) keine exakten Vielfachen der Bildrate sind, was die notwendige Bedingung für das stationäre Halten der Punkte ist auf dem Bildschirm, macht sie am auffälligsten.

Die 59.94-Rate wird aus den folgenden Berechnungen abgeleitet. Designer wählten, die Chrominanz-Hilfsträgerfrequenz auf ein n + 0,5-fachen der Zeilenfrequenz zu bringen, um die Interferenz zwischen dem Luminanzsignal und dem Chrominanzsignal zu minimieren. (Eine andere Möglichkeit, die oft genannt wird, ist, dass die Farbhilfsträgerfrequenz ein ungerades Vielfaches der halben Zeilenfrequenz ist.) Sie haben dann die Audio-Hilfsträgerfrequenz auf ein ganzzahliges Vielfaches der Zeilenfrequenz eingestellt, um sichtbare (Intermodulation) Interferenz zwischen den Audiodaten zu minimieren Signal und das Chrominanzsignal. Der ursprüngliche Schwarz-Weiß-Standard mit seiner Zeilenfrequenz von 15.750 Hz und dem Audio-Subträger mit 4,5 MHz erfüllt diese Anforderungen nicht, so dass die Entwickler entweder die Frequenz des Audio-Subträgers erhöhen oder die Zeilenfrequenz senken mussten. Ein Erhöhen der Audio-Hilfsträgerfrequenz würde verhindern, dass existierende (Schwarz-Weiß-) Empfänger das Audiosignal richtig abstimmen. Das Verringern der Zeilenfrequenz ist vergleichsweise unschädlich, da die horizontale und vertikale Synchronisationsinformation in dem NTSC-Signal es einem Empfänger ermöglicht, eine wesentliche Menge an Variation in der Zeilenfrequenz zu tolerieren. Also haben die Ingenieure die Linienfrequenz für den Farbstandard gewählt. Im Schwarz-Weiß-Standard beträgt das Verhältnis von Audio-Hilfsträgerfrequenz zu Zeilenfrequenz 4,5 MHz / 15 750 Hz = 285,71. Im Farbstandard wird dies auf die Ganzzahl 286 gerundet, was bedeutet, dass die Zeilenrate des Farbstandards 4,5 MHz / 286 × 15.734 Hz beträgt. Bei Beibehaltung der gleichen Anzahl von Abtastzeilen pro Feld (und Rahmen) muss die niedrigere Zeilenrate eine niedrigere Feldrate ergeben. Das Teilen von 4500000/286 Zeilen pro Sekunde mit 262,5 Zeilen pro Feld ergibt ungefähr 59,94 Halbbilder pro Sekunde.

Übertragungsmodulationsmethode

Ein übertragener NTSC-Fernsehkanal belegt eine Gesamtbandbreite von 6 MHz. Das eigentliche Videosignal, das amplitudenmoduliert ist, wird zwischen 500 kHz und 5,45 MHz oberhalb der Untergrenze des Kanals übertragen. Der Videoträger ist 1,25 MHz oberhalb der unteren Grenze des Kanals. Wie die meisten AM-Signale erzeugt der Videoträger zwei Seitenbänder, eines oberhalb des Trägers und eines unterhalb. Die Seitenbänder sind jeweils 4,2 MHz breit. Das gesamte obere Seitenband wird übertragen, aber nur 1,25 MHz des unteren Seitenbandes, das als Restseitenband bekannt ist, wird übertragen. Der Farbhilfsträger, wie oben erwähnt, ist 3,579545 MHz über dem Videoträger und ist mit einem unterdrückten Träger quadraturamplitudenmoduliert. Das Audiosignal ist frequenzmoduliert, ähnlich wie die Audiosignale, die von FM-Radiosendern im 88-108 MHz-Band gesendet werden, jedoch mit einer maximalen Frequenzabweichung von 25 kHz, im Gegensatz zu 75 kHz, wie es im FM-Band verwendet wird, wodurch analoges Fernsehen möglich ist Audiosignale klingen leiser als FM-Radiosignale, wie sie auf einem Breitbandempfänger empfangen werden. Der Haupt-Audio-Träger ist 4,5 MHz über dem Video-Träger, so dass er 250 kHz unter der Oberseite des Kanals liegt. Manchmal kann ein Kanal ein MTS-Signal enthalten, das mehr als ein Audiosignal bietet, indem ein oder zwei Unterträger dem Audiosignal hinzugefügt werden, die jeweils auf ein Vielfaches der Zeilenfrequenz synchronisiert sind. Dies ist normalerweise der Fall, wenn Stereo-Audio und / oder zweite Audio-Programmsignale verwendet werden. Die gleichen Erweiterungen werden in ATSC verwendet, wo der digitale ATSC-Träger bei 0,31 MHz über der unteren Grenze des Kanals gesendet wird.

„Setup“ ist ein Spannungsversatz von 54 mV (7,5 IRE) zwischen den „Schwarz“ – und „Austast“ -Pegeln. Es ist einzigartig für NTSC. CVBS steht für Color, Video, Blanking und Sync.

Bildrate-Konvertierung

Es gibt einen großen Unterschied in der Bildrate zwischen dem Film, der mit 24,0 Bildern pro Sekunde läuft, und dem NTSC-Standard, der bei ungefähr 29,97 (10 MHz × 63/88/455/525) Bildern pro Sekunde läuft. In Regionen, die 25-fps-Fernseh- und Videostandards verwenden, kann dieser Unterschied durch eine Beschleunigung überwunden werden.

Für 30-fps-Standards wird ein Prozess mit dem Namen „3: 2 Pulldown“ verwendet. Ein Film-Frame wird für drei Video-Felder übertragen (dauert 1½ Video-Frames), und der nächste Frame wird für zwei Video-Felder (für 1 Video-Frame) übertragen. Zwei Filmrahmen werden somit in fünf Videofeldern übertragen, für einen Durchschnitt von 2 1/2 Videofeldern pro Filmrahmen. Die durchschnittliche Bildrate beträgt also 60 ÷ 2,5 = 24 Bilder pro Sekunde, also ist die durchschnittliche Filmempfindlichkeit nominal genau so, wie sie sein sollte. (In Wirklichkeit werden im Verlauf einer Stunde Echtzeit 215.827,2 Videofelder angezeigt, was 86.330,88 Filmrahmen entspricht, während in einer Stunde echter 24-fps Filmprojektion genau 86.400 Bilder gezeigt werden: also 29,97 fps NTSC Die Übertragung von 24-fps-Film läuft bei 99,92% der normalen Filmgeschwindigkeit.) Still-framing bei der Wiedergabe kann einen Videorahmen mit Feldern von zwei verschiedenen Filmrahmen anzeigen, so dass jeder Unterschied zwischen den Rahmen als schnelle Rück- und weiter flimmern. Bei langsamen Kameraschwenks (Telecine Judder) kann es auch zu merklichem Jitter / „Stutter“ kommen.

Um einen 3: 2-Pulldown zu vermeiden, werden Filmaufnahmen speziell für NTSC-Fernsehgeräte oft mit 30 Bildern / s gemacht.

Um 25-fps-Material (wie europäische Fernsehserien und einige europäische Filme) auf NTSC-Geräten zu zeigen, wird jeder fünfte Frame dupliziert und dann wird der resultierende Stream interlaced.

Filmaufnahmen für NTSC-Fernsehen mit 24 Bildern pro Sekunde wurden traditionell um 1/24 (auf etwa 104,17% der normalen Geschwindigkeit) für die Übertragung in Regionen mit 25-fps-Fernsehstandards beschleunigt. Diese Erhöhung der Bildgeschwindigkeit wurde traditionell von einer ähnlichen Zunahme der Tonhöhe und des Tempos des Tons begleitet. In jüngerer Zeit wurde Frame-Blending verwendet, um 24 FPS-Video in 25 FPS zu konvertieren, ohne seine Geschwindigkeit zu ändern.

Filmaufnahmen für das Fernsehen in Regionen, die 25-fps-Fernsehstandards verwenden, können auf zwei Arten gehandhabt werden:

Der Film kann mit 24 Bildern pro Sekunde aufgenommen werden. In diesem Fall kann der Film, wenn er in seinem nativen Bereich übertragen wird, gemäß der oben beschriebenen analogen Technik auf 25 fps beschleunigt werden oder durch die oben beschriebene digitale Technik bei 24 fps gehalten werden. Wenn der gleiche Film in Regionen übertragen wird, die einen nominalen 30-fps-Fernsehstandard verwenden, gibt es keine merkliche Änderung in Geschwindigkeit, Tempo und Tonhöhe.

Der Film kann mit 25 Bildern pro Sekunde aufgenommen werden. In diesem Fall wird der Film, wenn er in seinem nativen Bereich übertragen wird, mit seiner normalen Geschwindigkeit gezeigt, wobei der zugehörige Soundtrack nicht verändert wird. Wenn derselbe Film in Regionen gezeigt wird, in denen ein 30-fps-Standard für die Fernsehnorm verwendet wird, wird jeder fünfte Frame dupliziert, und es gibt immer noch keine merkliche Änderung der Geschwindigkeit, des Tempos und der Tonhöhe.

Da beide Filmgeschwindigkeiten in 25-fps-Regionen verwendet wurden, können Zuschauer in Fernsehfilmen aus diesen Regionen Verwirrung über die tatsächliche Geschwindigkeit von Video und Audio und die Tonhöhe von Stimmen, Toneffekten und musikalischen Darbietungen erfahren. Zum Beispiel fragen sie sich vielleicht, ob die Jeremy-Brett-Serie von Sherlock Holmes-Fernsehfilmen, die in den 1980er und frühen 1990er Jahren entstanden, mit 24 fps gedreht und dann in 25-fps-Regionen mit künstlich hoher Geschwindigkeit übertragen wurde oder ob sie angeschossen wurde 25 fps nativ und verlangsamte dann für die NTSC-Ausstellung auf 24 fps.

Diese Diskrepanzen bestehen nicht nur bei Fernsehsendungen über Funk und Kabel, sondern auch auf dem Heimvideomarkt, sowohl auf Band als auch auf Disc, einschließlich Laserdisc und DVD.

Im digitalen Fernsehen und Video, die ihre analogen Vorgänger ersetzen, zeigen einzelne Standards, die eine größere Bandbreite von Bildfrequenzen aufnehmen können, immer noch die Grenzen analoger regionaler Standards. Der ATSC-Standard ermöglicht zum Beispiel Bildraten von 23,976, 24, 29,97, 30, 59,94 und 60 Bildern pro Sekunde, aber nicht 25 und 50.

Modulation für analoge Satellitenübertragung

Da die Satellitenleistung stark eingeschränkt ist, unterscheidet sich die analoge Videoübertragung über Satelliten von der terrestrischen TV-Übertragung. AM ist ein lineares Modulationsverfahren, so dass ein gegebenes demoduliertes Signal-Rausch-Verhältnis (SNR) ein gleich hohes empfangenes RF-SNR erfordert. Das SNR von Video in Studioqualität ist über 50 dB, so dass AM unerschwinglich hohe Leistungen und / oder große Antennen erfordern würde.

Breitband-FM wird stattdessen verwendet, um die HF-Bandbreite für reduzierte Leistung zu tauschen. Eine Erhöhung der Kanalbandbreite von 6 auf 36 MHz ermöglicht ein RF-SNR von nur 10 dB oder weniger. Die breitere Rauschbandbreite reduziert diese 40-dB-Energieeinsparung um 36 MHz / 6 MHz = 8 dB für eine erhebliche Nettoreduktion von 32 dB.

Der Ton ist auf einem FM-Unterträger wie bei der terrestrischen Übertragung, jedoch werden Frequenzen über 4,5 MHz verwendet, um hörbare / visuelle Interferenz zu reduzieren. Üblicherweise werden 6,8, 5,8 und 6,2 MHz verwendet. Stereo kann multiplex, diskret oder Matrix sein, und nicht verwandte Audio- und Datensignale können auf zusätzlichen Unterträgern platziert werden.

Eine dreieckige 60-Hz-Energieverteilungswellenform wird zu dem zusammengesetzten Basisbandsignal (Video plus Audio- und Datensubträger) vor der Modulation hinzugefügt. Dies begrenzt die Leistungsspektraldichte der Satelliten-Abwärtsverbindung, falls das Videosignal verloren geht. Andernfalls könnte der Satellit seine gesamte Leistung auf einer einzigen Frequenz übertragen, wodurch terrestrische Mikrowellenverbindungen im selben Frequenzband gestört würden.

Im Halbtranspondermodus wird die Frequenzabweichung des zusammengesetzten Basisbandsignals auf 18 MHz reduziert, um ein anderes Signal in der anderen Hälfte des 36 MHz-Transponders zu ermöglichen. Dies verringert den FM-Nutzen etwas, und die wiederhergestellten SNRs werden weiter verringert, da die kombinierte Signalleistung „zurückgesetzt“ werden muss, um eine Intermodulationsverzerrung im Satellitentransponder zu vermeiden. Ein einzelnes FM-Signal hat eine konstante Amplitude, so dass es einen Transponder ohne Verzerrung sättigen kann.

Feldreihenfolge

Ein NTSC- „Rahmen“ besteht aus einem „geraden“ Feld gefolgt von einem „ungeraden“ Feld. Was den Empfang eines analogen Signals betrifft, ist dies nur eine Frage der Konvention und macht keinen Unterschied. Es ist eher wie die gestrichelten Linien, die in der Mitte einer Straße verlaufen, es spielt keine Rolle, ob es ein Linie / Raum-Paar oder ein Raum / Linien-Paar ist; Der Effekt für einen Fahrer ist genau der gleiche.

Die Einführung digitaler Fernsehformate hat einiges verändert. Die meisten digitalen TV-Formate speichern und übertragen Felder in Paaren als einen einzigen digitalen Rahmen. Digitale Formate, die der NTSC-Halbbildrate entsprechen, einschließlich des populären DVD-Formats, nehmen Video mit dem geraden Feld zuerst im digitalen Bild auf, während die Formate, die mit der Halbbildrate des 625-Zeilensystems übereinstimmen, häufig Video mit ungeradem Halbbild aufnehmen. Dies bedeutet, dass bei der Wiedergabe vieler nicht auf NTSC basierender digitaler Formate die Halbbildreihenfolge umgekehrt werden muss, da andernfalls ein unannehmbarer „Kamm“ -Effekt bei sich bewegenden Objekten auftritt, wenn sie in einem Feld voraus gezeigt werden und dann im nächsten zurückspringen.

Dies ist auch zu einer Gefahr geworden, wenn Non-NTSC-Progressive-Video in Interlaced und umgekehrt transkodiert wird. Systeme, die progressive Frames wiederherstellen oder Video transkodieren, sollten sicherstellen, dass die „Feldreihenfolge“ befolgt wird, andernfalls besteht der wiederhergestellte Frame aus einem Feld von einem Frame und einem Feld von einem benachbarten Frame, was zu „Kamm“ -Interlacing-Artefakten führt. Dies kann oft in PC-basierten Videowiedergabe-Dienstprogrammen beobachtet werden, wenn eine unpassende Wahl des Deinterlacing-Algorithmus getroffen wird.

Während der Jahrzehnte der Hochleistungs-NTSC-Übertragungen in den Vereinigten Staaten wurde das Umschalten zwischen den Ansichten von zwei Kameras nach zwei Standards durchgeführt, wobei die Wahl zwischen den beiden durch Geographie, Ost gegen West, getroffen wurde. In einer Region wurde zwischen dem ungeraden Feld, das ein Bild beendet hat, und dem geraden Feld, das das nächste Bild begonnen hat, umgeschaltet; in der anderen wurde der Wechsel nach einem geraden Feld und vor einem ungeraden Feld vorgenommen. So würde zum Beispiel eine Heim-VHS-Aufzeichnung, die von einer lokalen Fernsehnachricht im Osten gemacht wurde, wenn sie pausiert war, immer nur die Ansicht von einer Kamera zeigen (außer eine Überblend- oder andere Multikamera-Aufnahme beabsichtigt war), während VHS-Wiedergabe einer Situationskomödie aufgenommen und bearbeitet in Los Angeles und dann landesweit übertragen, könnte im Moment eines Wechsels zwischen Kameras mit der Hälfte der Linien unterbrochen werden, die den ausgehenden Schuss darstellen und die andere Hälfte den eingehenden Schuss darstellt.